当ChatGPT遇上数据瓶颈,该怎么办?

随着人工智能技术的迅速发展,ChatGPT作为一种强大的自然语言处理工具,已广泛应用于各行各业。当ChatGPT遭遇数据瓶颈时,很多企业和开发者开始面临一系列挑战。数据瓶颈的存在不仅影响模型的响应速度和准确性,还可能降低用户体验并增加系统的维护成本。当ChatGPT遇上数据瓶颈时,我们该如何有效应对?本文将探讨可能的解决方案,并介绍如何利用DataFocus这样的数据管理工具,优化AI系统的数据流和计算效率,从而提升ChatGPT的性能和稳定性。

什么是数据瓶颈?

数据瓶颈是指在数据处理、传输或存储过程中,由于某些环节的限制,导致整体系统效率大幅下降。在AI应用中,尤其是像ChatGPT这样的深度学习模型,数据瓶颈通常出现在数据的获取、预处理、存储以及计算能力方面。具体来说,数据瓶颈可能会表现为模型训练时速度缓慢、预测响应时间过长、或是模型处理数据时出现延迟。这些瓶颈不仅影响模型的表现,还可能导致硬件资源的浪费,增加了开发和维护的复杂度。

ChatGPT面临的常见数据瓶颈

-

数据量过大,存储与处理能力不足

ChatGPT依赖大量的数据进行训练和推理,而这些数据的体量通常非常庞大。如果系统的存储和处理能力不足,AI模型可能会面临无法快速访问或处理这些数据的困境,从而导致性能下降。 -

数据处理与清洗的效率问题

数据处理和清洗是AI训练过程中至关重要的一部分。如果数据中存在噪声或不完整的部分,处理这些数据将需要大量的时间和计算资源。过多的无效数据不仅增加了计算负担,也可能影响模型的学习效果。

-

数据传输速度瓶颈

在分布式AI系统中,数据的传输速度往往是决定模型训练和推理速度的重要因素。如果网络带宽不足或数据传输过程中的延迟过高,将导致信息传递速度减慢,从而影响整体性能。 -

实时数据处理需求的挑战

ChatGPT应用场景多样,很多情况下需要进行实时数据处理。在这些应用中,数据处理的实时性要求极高,任何延迟都可能导致用户体验的严重下降。如何在大规模数据流的环境下保持高效处理是一个挑战。

如何应对ChatGPT的数据瓶颈?

-

优化数据存储和处理架构 当ChatGPT遇到数据瓶颈时,首先需要优化数据存储和处理架构。这包括采用分布式存储和计算技术,充分利用云计算平台的弹性扩展能力,以及选择高效的数据库和数据缓存系统。利用硬件加速(如GPU、TPU)也能显著提高数据处理速度。

-

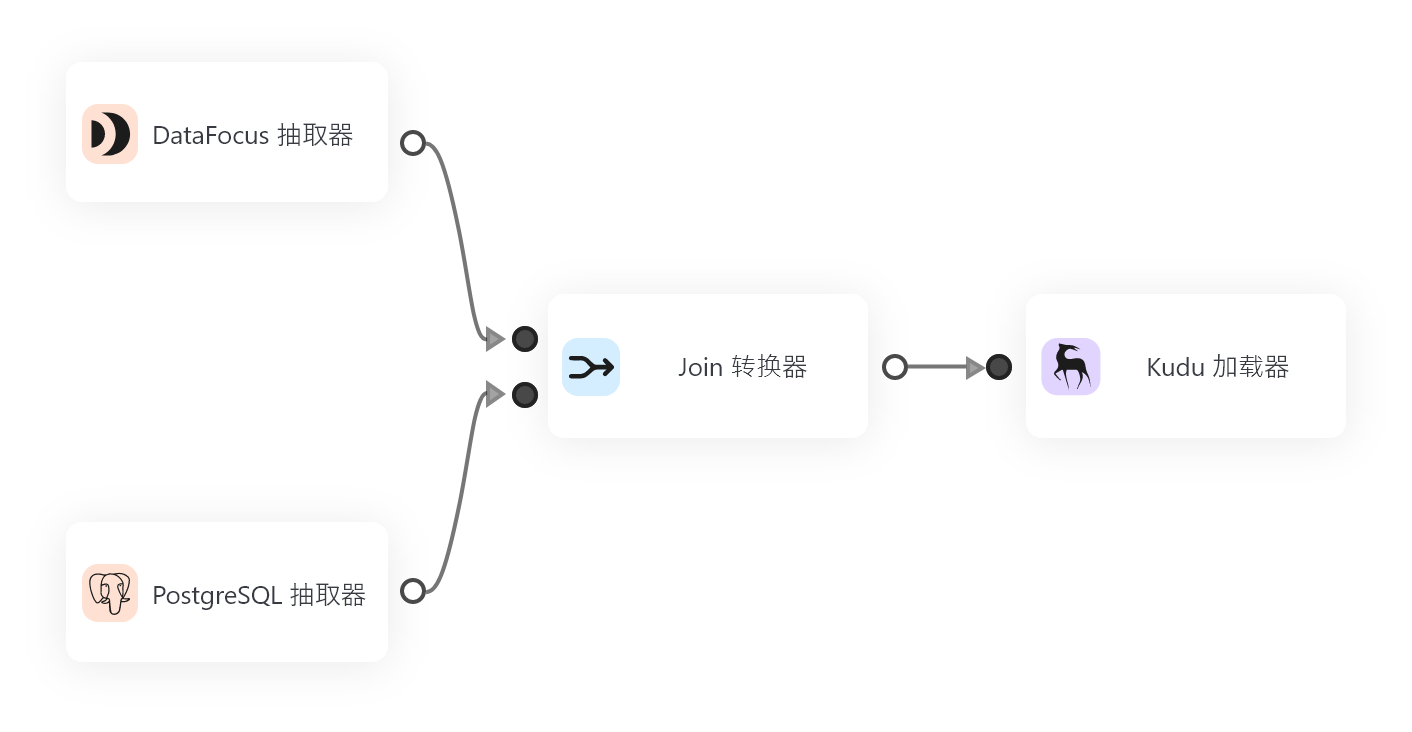

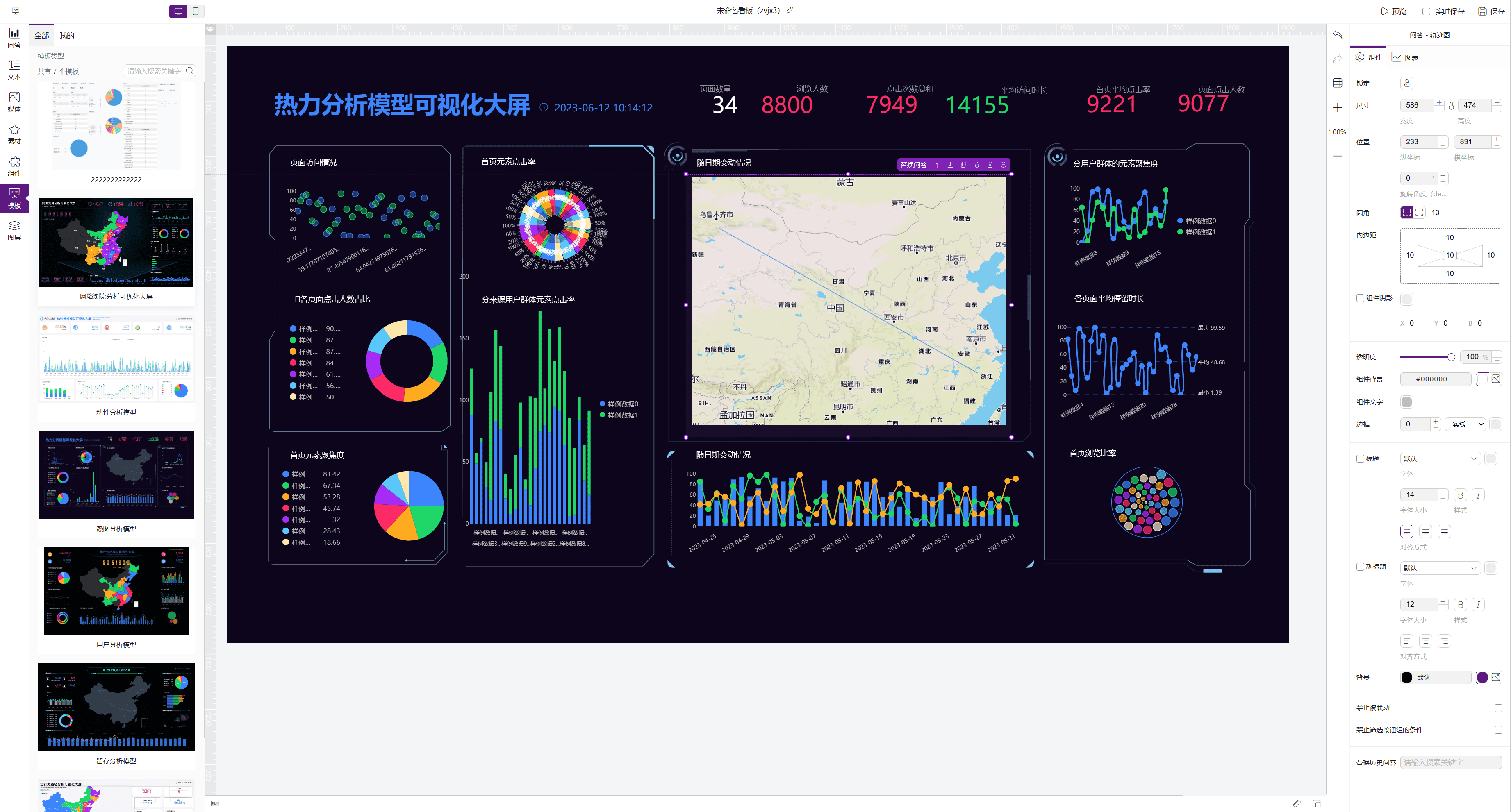

使用DataFocus进行数据管理与优化 针对ChatGPT的具体需求,DataFocus作为一款专业的数据管理工具,可以帮助开发者高效地管理和优化大数据集。DataFocus通过智能数据清洗和预处理功能,帮助去除数据中的噪声,确保输入到AI模型中的数据质量更高,减少数据处理时间。DataFocus还支持灵活的数据存储与分发,可以帮助优化数据传输效率,避免因数据传输瓶颈导致的性能问题。

-

数据分片与并行处理 为了解决数据处理速度的问题,可以采用数据分片技术。将庞大的数据集划分成多个小块,并进行并行处理,可以大幅提升计算效率。在多核或分布式计算环境中,采用分布式计算框架(如Apache Spark、Hadoop等)可以进一步优化处理过程,缩短数据处理和模型训练的时间。

-

模型精简与优化

当面对计算资源和数据瓶颈时,另一个解决方案是对模型进行精简。通过模型剪枝、量化以及蒸馏技术,可以在不损失模型性能的情况下,减少模型的计算和存储需求。这样可以有效减轻数据瓶颈对系统的负担,提高模型推理速度。 -

动态调整计算资源

现代云平台提供了动态扩展计算资源的能力,开发者可以根据数据流量和计算负载的实时变化,灵活调整计算资源。例如,在数据处理量较大的时段,通过自动增加计算节点来提高处理能力,避免因资源不足而导致的瓶颈。

-

优化数据传输管道 如果数据传输速度成为瓶颈,开发者可以通过优化数据传输管道来解决这一问题。这包括使用高效的压缩算法、优化数据序列化方式、减少不必要的数据传输等措施。采用CDN(内容分发网络)技术,也可以加速跨地域的数据访问,提高数据传输效率。

结语

ChatGPT在面临数据瓶颈时,如何有效解决这些问题是提升系统性能和用户体验的关键。通过采用高效的数据管理工具如DataFocus,优化数据存储、处理和传输管道,开发者能够从根本上解决数据瓶颈问题,提升模型的处理效率。AI技术的发展离不开高质量的数据支持,而高效的数据管理则是推动这一进程的核心。对于企业和开发者而言,了解和应对数据瓶颈不仅是技术挑战,更是提升AI应用价值和可持续发展的必由之路。

通过实施上述优化措施,我们可以确保ChatGPT等人工智能模型在面对大规模数据时,仍能保持高效、稳定的性能,进而为用户提供更精准、更及时的智能服务。