大数据分析的基本流程是什么?

在当今数据驱动的时代,大数据分析已成为企业决策的重要工具。无论是互联网公司、金融机构还是政府部门,都面临着海量数据的处理与分析需求。对于初学者或企业新手来说,了解大数据分析的基本流程是掌握这一技术的关键。本文将详细解读大数据分析的基本流程,并结合实际应用场景,帮助读者更好地理解数据分析的过程。

1. 数据采集(Data Collection)

大数据分析的第一步是数据采集。数据来源可以是企业内部的数据库、外部的API接口、社交媒体平台、传感器设备(物联网数据)或者其他任何形式的数据源。数据采集的关键在于确保数据的完整性和准确性。

- 常见的数据采集方式:

- 结构化数据:如数据库中的表格数据(SQL、NoSQL)。

- 半结构化数据:如JSON、XML格式的数据。

- 非结构化数据:如文本、图像、音频、视频等。

- 挑战: 数据采集过程中可能会遇到数据格式不一致、数据量过大、采集速率过快等问题,需要选择合适的技术来处理。

适用于数据采集的技术:

- 数据库:MySQL、PostgreSQL、MongoDB等。

- 大数据框架:如 Apache Kafka(实时数据流)、Flume(日志数据采集)。

- 文件存储:如Hadoop HDFS、云存储(AWS S3、阿里云OSS)。

2. 数据处理(Data Processing)

数据采集完成后,接下来是对数据进行处理。这个阶段的目标是将原始数据转化为适合分析和建模的形式。

- 数据清洗(Data Cleaning):

- 处理缺失值、重复值、异常值。

- 例如,删除或补充缺失的数据点,剔除明显错误的记录。

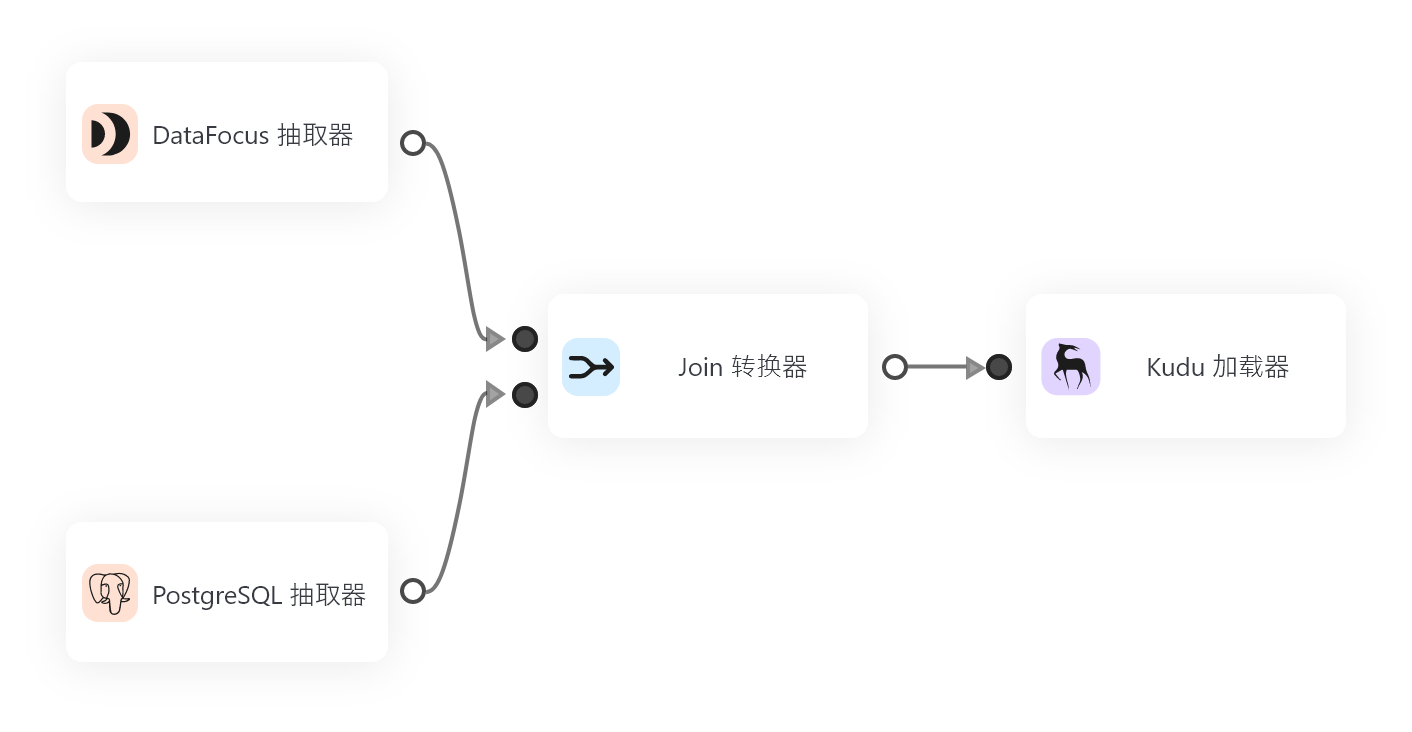

- 数据集成(Data Integration):

- 将来自不同数据源的数据合并在一起,确保数据的一致性和完整性。

- 例如,将销售数据、用户行为数据和市场活动数据整合到一起,进行综合分析。

- 数据转换(Data Transformation):

- 对数据进行格式转换、标准化、归一化处理。

- 例如,将日期格式统一,将分类变量转换为数值变量。

数据处理的关键工具和技术:

- 大数据处理框架:如 Apache Spark、Flink。

- 数据流处理:如 Apache Kafka、Storm。

- ETL 工具:如 Apache Nifi、Informatica。

3. 数据存储(Data Storage)

经过处理后的数据需要存储在合适的位置,以便后续的分析和查询。

- 常用的存储技术:

- 分布式文件系统:如 Hadoop HDFS、阿里云 OSS。

- 关系型数据库:如 MySQL、PostgreSQL。

- NoSQL 数据库:如 MongoDB、Hbase。

- 大数据仓库:如 Apache Hadoop、Apache HIVE。

- 云存储:如 AWS S3、阿里云 Hadoop、腾讯云 COS。

数据存储的选择依据:

- 数据量大小。

- 数据的访问模式(实时查询 vs 批处理)。

- 数据的类型(结构化 vs 非结构化)。

- 数据的生命周期(长期保存 vs 短期保存)。

4. 数据建模与分析(Data Modeling & Analysis)

数据建模和分析是大数据分析的核心环节。这一步的目标是通过数据分析技术,从数据中提取有用的信息和洞察。

-

数据建模(Data Modeling):

-

将数据转化为适合分析的模型。

-

常见的数据模型包括:决策树、随机森林、神经网络、支持向量机等。

-

数据建模的目标是提高数据分析的准确性和效率。

-

数据分析(Data Analysis):

-

描述性分析:总结数据的基本特征,如均值、中位数、标准差等。

-

诊断性分析:分析数据背后的原因,如用户流失的原因分析。

-

预测性分析:基于历史数据预测未来的趋势,如销售预测、信用评分。

-

规范性分析:提供优化建议,如供应链优化、资源分配。

数据分析的关键技术:

- 机器学习:如监督学习、无监督学习、深度学习。

- 统计分析:如回归分析、聚类分析、时间序列分析。

- 大数据分析框架:如 Apache Spark、Flink。

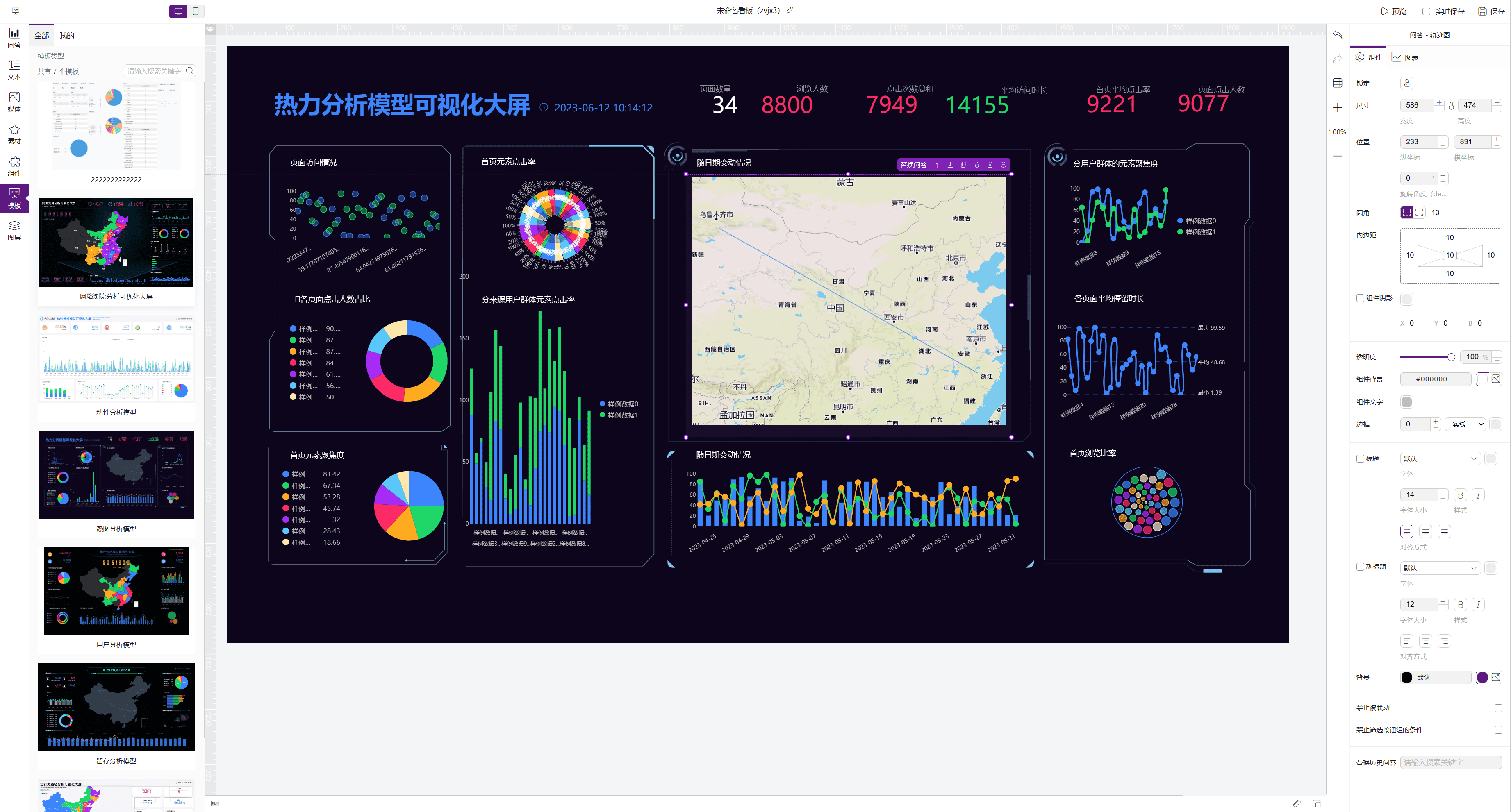

5. 数据可视化与报表生成(Data Visualization & Reporting)

数据分析的最终目的是将结果以直观、易懂的方式呈现给用户。数据可视化和报表生成是这一阶段的重要工作。

- 数据可视化:

- 使用图表、图形、仪表盘等方式展示数据分析结果。

- 常见的可视化工具包括:Tableau、Power BI、ECharts、DataFocus BI。

- 报表生成:

- 将分析结果整理成报告文档,供企业决策者参考。

- 报表内容通常包括数据摘要、分析结果、优化建议等。

常用的数据可视化工具:

- 商业智能工具:如 Tableau、Power BI。

- 开源工具:如 Apache ECharts、D3.js。

- 现代 BI 工具:如 DataFocus BI,支持中英双语问答交互式分析,提供高度灵活的数据探索体验。

6. 数据驱动的决策与优化(Decision Making & Optimization)

数据分析的最终目标是支持企业决策,并通过优化提升业务绩效。

- 数据驱动的决策:

- 基于数据分析结果制定业务策略。

- 例如,根据用户行为分析结果优化营销策略,根据销售数据分析结果调整库存管理。

- 持续优化:

- 数据分析是一个持续迭代的过程,需要根据实际效果不断优化模型和方法。

- 例如,通过 A/B 测试验证营销策略的有效性,并根据测试结果调整策略。

总结

大数据分析的基本流程包括数据采集、数据处理、数据存储、数据建模与分析、数据可视化与报表生成,以及数据驱动的决策与优化。每个环节都需要选择合适的技术和工具,确保数据处理和分析的高效性。

对于中小企业来说,选择一个高效的工具来完成数据分析至关重要。DataFocus BI 和 DataFocus Cloud 是两个值得推荐的工具。DataFocus BI 是新一代的搜索式 BI 产品,支持中英双语问答交互式分析,大大提升了数据探索的效率;DataFocus Cloud 则是一个云端的数据分析全家桶,集数仓、报表、大屏看板和搜索式 BI 于一体,非常适合中小企业快速上云,实现数据驱动的业务目标。

希望这篇文章能帮助您更好地理解大数据分析的基本流程,并为您的数据分析之旅提供一些启发!如果还有其他问题,欢迎随时留言交流。