ChatGPT的不足之处,你知道多少?

随着人工智能技术的飞速发展,ChatGPT作为一款强大的语言生成模型,已经被广泛应用于各个行业,如客户服务、内容创作、编程辅助等。尽管ChatGPT在许多领域展现了其强大的能力,但它依然存在一定的不足之处。这些不足不仅影响了其在某些场景中的表现,也为使用者带来了一定的挑战。因此,在本文中,我们将深入探讨ChatGPT的不足之处,并分析这些问题对使用者的影响,帮助用户更好地理解和应对这些挑战。

1. 语言理解和生成的局限性

尽管ChatGPT在自然语言处理上表现出色,但它在某些复杂的语言理解和生成任务上仍存在一定的局限性。尤其在涉及深层次语义分析时,ChatGPT有时可能会产生不准确或不相关的回应。例如,在处理长篇文章或复杂对话时,ChatGPT可能会失去上下文,导致生成的内容缺乏逻辑性或者出现语义混淆。这种局限性使得它在一些需要精确理解和推理的场景中,无法完全替代人类的判断力。

2. 信息的时效性问题

ChatGPT的知识库基于它训练时的数据集,这意味着它的知识是静态的,无法实时获取新的信息。因此,ChatGPT的回答往往停留在它训练时的数据范围内,无法及时更新某些领域的最新资讯和事件。这对于一些需要即时获取、准确回应新兴问题或快速变化的信息的场景来说,显然是一个限制。

3. 缺乏情感和人类共鸣

虽然ChatGPT能够生成语言流畅、符合语法规则的回答,但它缺乏真正的情感和人类共鸣。对于需要情感支持或个性化互动的场景,ChatGPT往往无法提供足够的深度和真实感。无论是在心理咨询、情感沟通还是客户服务等领域,ChatGPT的“机械化”回答可能会让用户感到疏离或不够贴心。

4. 对多义词和歧义的处理不足

在自然语言中,许多词语或句子可能存在歧义,ChatGPT有时在处理这些歧义时表现不尽人意。它可能无法准确理解词语的多重含义或在复杂上下文中做出最合适的解读。这种问题在涉及专业术语、行业用语或具有多层次含义的文本时尤为明显,可能导致输出结果偏离用户的真实需求。

5. 对道德和伦理问题的处理

ChatGPT的训练数据来自广泛的互联网内容,其中可能包含各种观点、信仰和价值观。尽管它有一定的过滤机制,但在面对涉及道德和伦理的问题时,ChatGPT仍然可能生成不合适或具有争议性的回应。例如,某些敏感话题可能会引发不必要的争议,或者由于缺乏深刻的伦理判断,给出不够妥当的建议。

6. 技术依赖与误导性信息

由于ChatGPT的输出高度依赖于其训练数据和模型的设计,它可能会生成某些误导性信息或不准确的内容。尤其在某些技术领域,ChatGPT可能没有足够的深度理解,导致给出的答案不完全准确或过于简化。这种误导性信息的存在,对使用者的决策和理解可能带来一定的风险,尤其是在科研、法律、医学等高度专业化的领域。

7. 安全性和隐私问题

虽然OpenAI已在设计ChatGPT时考虑了数据隐私和安全问题,但用户在与ChatGPT互动时仍然可能面临信息泄露和隐私风险。尤其是在没有严格数据保护措施的情况下,个人信息、商业机密等敏感数据的泄露问题,仍然是用户需要考虑的重要因素。为此,在使用ChatGPT等AI工具时,用户必须谨慎处理个人信息和公司数据。

8. 如何通过DataFocus弥补不足

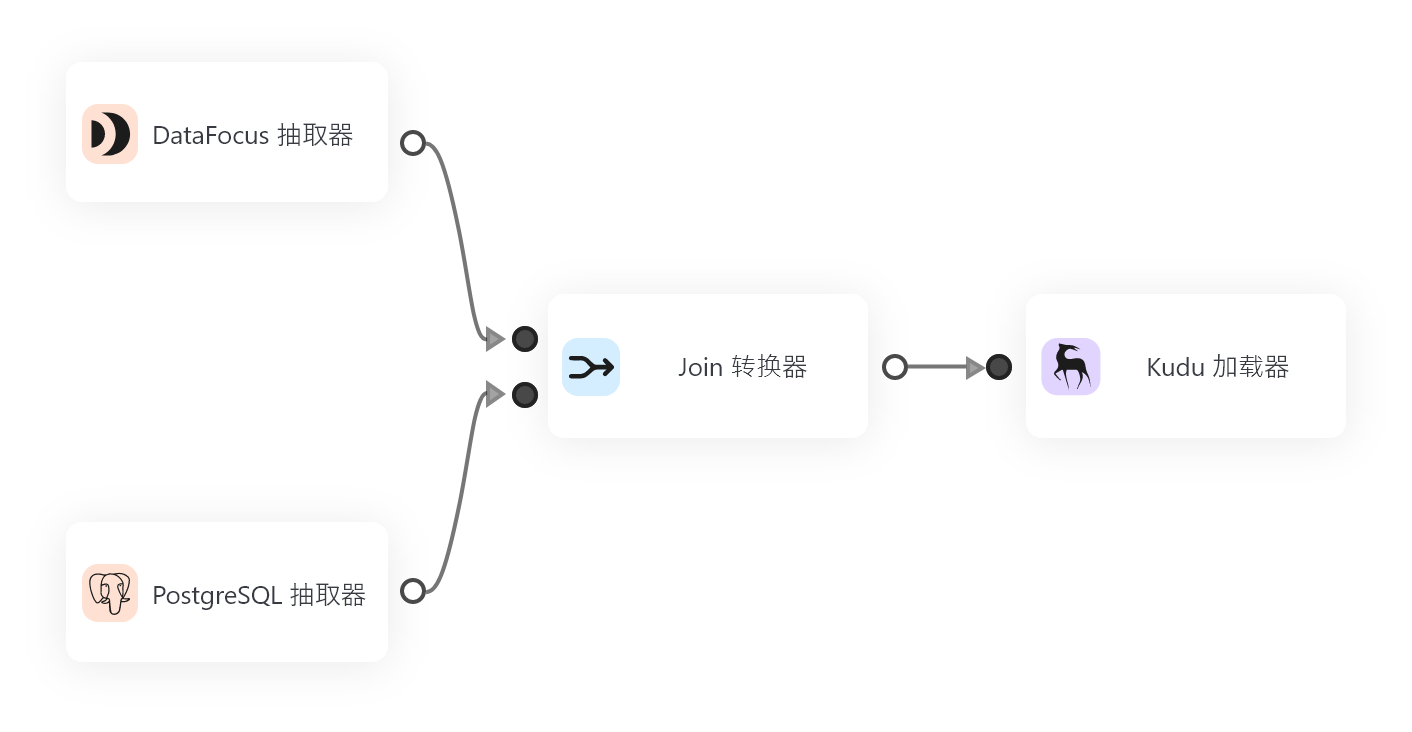

为了克服ChatGPT在实际应用中的不足,企业可以借助数据分析和智能工具的补充,例如“DataFocus”。DataFocus是一款专业的分析工具,能够帮助用户更好地获取实时数据、深入分析数据的趋势和变化。通过结合ChatGPT的语言生成能力和DataFocus的精确数据分析,用户可以在获取信息的更好地进行决策和预测,从而弥补ChatGPT在信息时效性和深度分析方面的不足。DataFocus能够为企业提供精准的市场趋势分析、消费者行为预测以及关键数据的深度洞察,确保用户可以获得最新、最准确的决策支持。

结语

虽然ChatGPT在许多应用场景中展现了卓越的能力,但它仍存在着语言理解、时效性、情感共鸣等方面的不足。对于那些希望在复杂任务中获得精确结果的用户,理解并应对这些挑战至关重要。通过结合像DataFocus这样的智能数据分析工具,用户可以弥补ChatGPT的局限性,充分发挥人工智能在实际工作中的潜力。未来,随着技术的不断进步,ChatGPT及类似工具的不足有望得到进一步改善,但在当前阶段,理性使用和优化搭配仍然是最佳选择。