在当今数据驱动的世界中,构建一个高效且准确的大数据模型是企业获取竞争优势的关键。无论你是数据科学家、分析师还是产品经理,掌握如何构建一个有效的大数据模型都是一项至关重要的技能。在本文中,我将深入探讨如何构建一个有效的大数据模型,并提供一些实用的建议和工具推荐,帮助你在数据分析和建模过程中更加得心应手。

第一步:明确业务目标

构建大数据模型的第一步是明确业务目标。数据模型的目的是为了支持业务决策,而不是为了展示复杂的数学算法。因此,在开始建模之前,你需要清楚地了解以下几个问题:

-

问题是什么? 你试图解决的具体业务问题是什幺?例如,是预测客户流失、优化供应链,还是提高广告点击率?

-

目标是什么? 你希望通过模型实现什幺?例如,预测未来的销售趋势、分类客户群体,还是优化资源配置?

-

数据可用性如何? 你有多少数据?数据的质量如何?是否存在缺失值、重复值或噪声?

-

时间范围是什么? 你的模型需要覆盖的时间范围是什幺?是实时预测,还是基于历史数据的分析?

通过明确业务目标,你可以避免在建模过程中偏离方向,并确保模型能够真正为企业创造价值。

第二步:数据准备与清洗

构建大数据模型的核心在于数据。高质量的数据是模型准确性的基础,因此在建模之前,你需要进行数据准备和清洗。

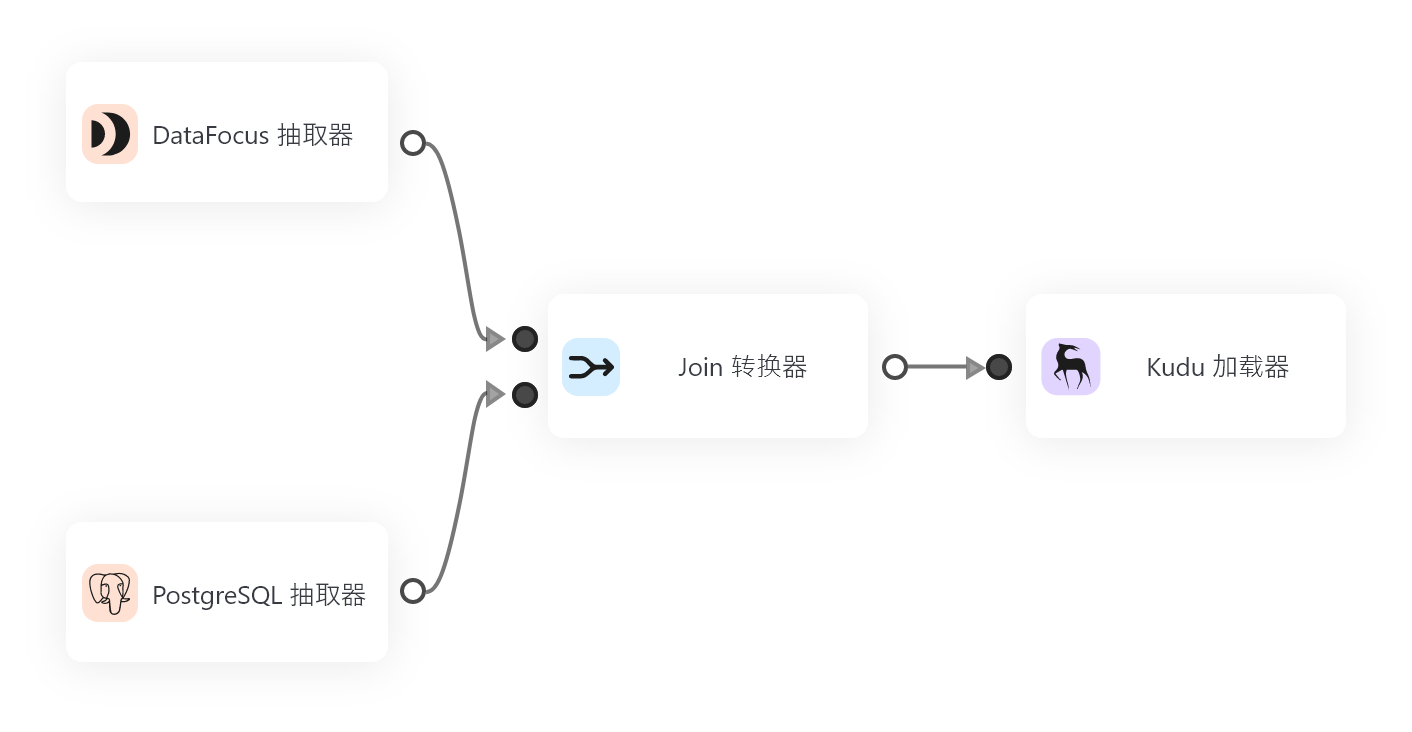

1. 数据来源

数据可以来自多种渠道,包括数据库、日志文件、API接口、传感器等。你需要确保数据的来源是可靠的,并且能够满足业务需求。

2. 数据清洗

在进行建模之前,数据清洗是非常重要的一环。数据清洗的目标是去除噪声数据、缺失值和异常值,确保数据的完整性和一致性。常见的数据清洗步骤包括:

- 去除重复数据: 确保数据中没有重复记录。

- 处理缺失值: 对于缺失值,可以选择删除相关记录、填充为均值/中位数,或者使用插值方法。

- 去除异常值: 通过统计方法(如Z-score)或机器学习方法(如Isolation Forest)识别并去除异常值。

- 标准化/归一化: 对于数值特征,可以选择将其标准化(StandardScaler)或归一化(Min-MaxScaler)。

3. 数据分割

在进行建模之前,通常需要将数据划分为训练集、验证集和测试集:

- 训练集(Training Data): 用于模型的训练。

- 验证集(Validation Data): 用于调整模型的超参数。

- 测试集(Test Data): 用于评估模型的最终性能。

第三步:选择合适的算法

在进行建模之前,你需要根据业务需求和数据特征选择合适的算法。常见的算法包括:

1. 监督学习算法

适用于有标签的数据,目标是预测具体的输出结果。

- 线性回归(Linear Regression): 用于预测连续型变量。

- 支持向量机(SVM): 用于分类和回归。

- 随机森林(Random Forest): 适用于分类和回归,具有高准确性和鲁棒性。

- 梯度提升树(GBDT、XGBoost、LightGBM): 适用于分类和回归,性能强大。

- 神经网络(Neural Networks): 适用于复杂的非线性问题。

2. 无监督学习算法

适用于无标签的数据,目标是发现数据中的隐含模式。

- 聚类算法(K-means、DBSCAN): 用于客户分群、异常检测。

- 主成分分析(PCA): 用于降维和特征提取。

3. 时间序列算法

适用于时间序列数据,目标是预测未来的趋势。

- ARIMA: 适用于线性趋势的时间序列。

- LSTM: 适用于非线性时间序列,具有长期记忆能力。

4. 混合算法

适用于复杂场景,结合多种算法的优势。

- 集成学习(Ensemble Learning): 通过结合多个模型的结果来提高准确性。

- Pipeline流程: 将多个模型串联起来,例如先进行特征选择,再进行预测。

在选择算法时,你需要根据数据的特性和业务需求进行权衡。例如,如果数据量较小,可以选择随机森林或XGBoost;如果数据量较大且需要实时预测,可以选择LSTM或SVM。

第四步:模型训练与调优

1. 模型训练

将训练集数据输入到模型中,训练模型的参数,使其能够适应训练数据的模式。

2. 模型调优

模型调优的目标是找到最佳的超参数,以提高模型的性能。超参数包括:

- 学习率(Learning Rate): 控制模型更新的速度。

- 树深度(Tree Depth): 控制模型的复杂度。

- 正则化参数(Regularization Parameters): 防止模型过拟合。

- 特征选择参数(Feature Selection Parameters): 控制特征的选择。

常用的调优方法包括:

- 网格搜索(Grid Search): 尝试不同的超参数组合,找到最佳组合。

- 随机搜索(Random Search): 在超参数空间中随机采样,找到最佳组合。

- 贝叶斯优化(Bayesian Optimization): 使用贝叶斯方法优化超参数。

第五步:模型评估与优化

1. 模型评估

评估模型的性能是至关重要的一步。常用的评估指标包括:

- 准确率(Accuracy): 适用于分类问题,表示模型预测正确的比例。

- 精确率(Precision): 表示模型预测为正的实际为正的比例。

- 召回率(Recall): 表示模型预测为正的实际为正的比例。

- F1分数(F1 Score): 综合精确率和召回率的指标。

- 均方误差(MSE): 适用于回归问题,表示预测值与真实值的平均平方差。

- R平方(R²): 适用于回归问题,表示模型解释了多少比例的方差。

2. 模型优化

在评估模型性能后,你需要根据评估结果进行优化。优化的方向包括:

- 特征工程(Feature Engineering): 通过创建新特征或删除不相关特征来提高模型性能。

- 模型选择(Model Selection): 尝试不同的算法,找到最适合当前数据的算法。

- 数据增强(Data Augmentation): 通过生成新数据来增加数据量,提高模型的泛化能力。

第六步:模型部署与监控

1. 模型部署

当模型训练完成并经过充分验证后,下一步是将模型部署到生产环境中。常见的部署方式包括:

- API服务: 将模型封装为API,供其他系统调用。

- 批量处理: 将模型应用于批量数据,生成预测结果。

- 实时预测: 将模型应用于实时数据流,提供实时预测。

2. 模型监控

在模型部署后,需要对其进行持续监控,以确保其性能在变化的环境中仍然保持稳定。常见的监控指标包括:

- 模型准确率: 定期评估模型的预测准确性。

- 数据分布变化: 监控数据分布的变化,发现数据漂移(Data Drift)。

- 模型性能变化: 监控模型性能的变化,发现模型退化(Model Drift)。

工具推荐:DataFocusBI 和 DataFocus Cloud

在大数据模型的构建过程中,选择合适的工具可以事半功倍。以下是一些推荐的工具:

1. 数据分析与建模工具

- DataFocusBI: 一款基于搜索式的BI工具,支持中英双语交互,适合快速探索数据和构建模型。

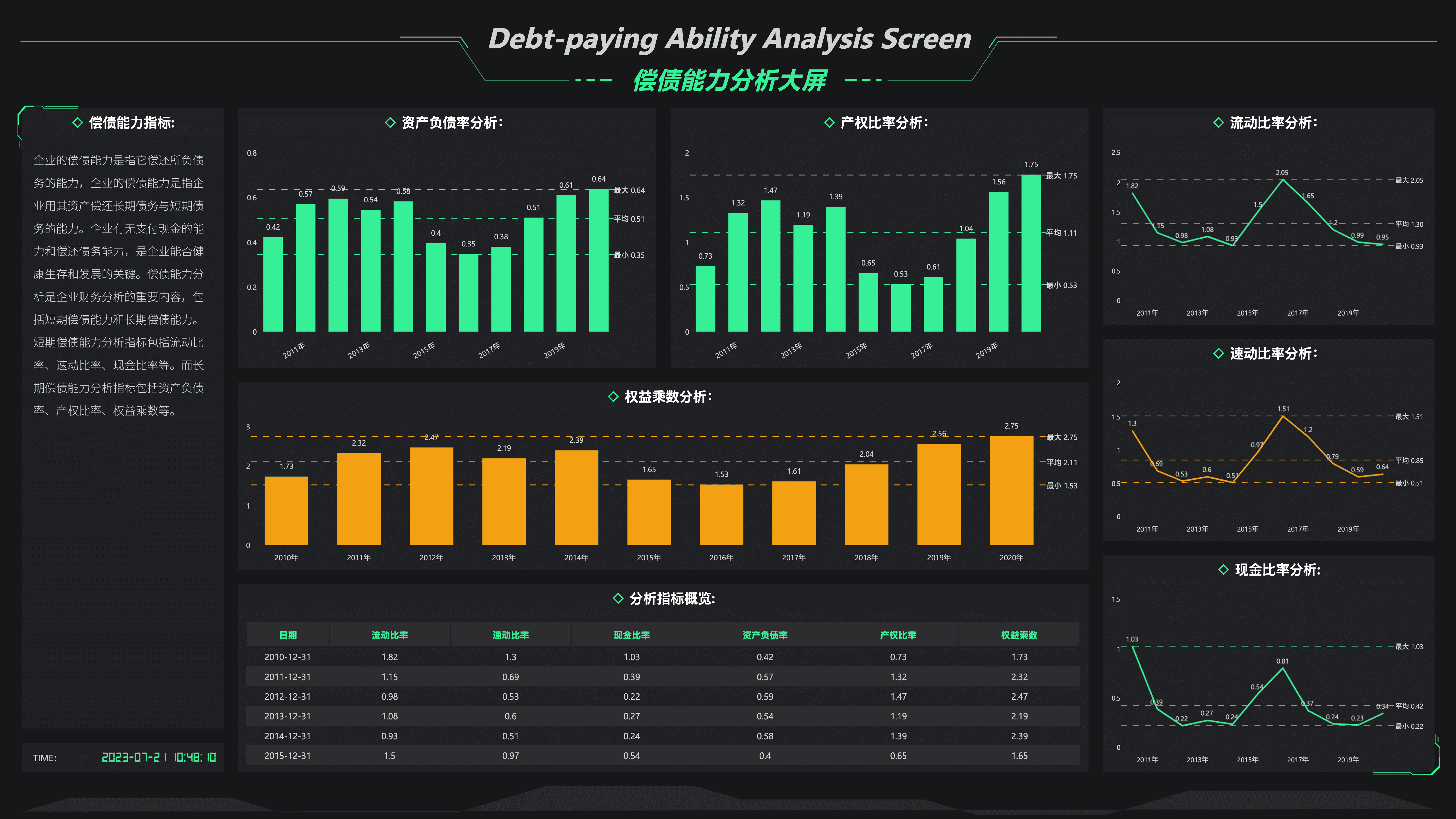

- DataFocus Cloud: 一款云端数据分析全家桶,集成了数仓、报表、大屏看板和搜索式BI,适合中小企业和大型企业的私有部署。

2. 机器学习框架

- Scikit-learn: 适合Python用户,功能强大,支持多种算法。

- XGBoost、LightGBM: 适合需要高性能和高准确性的场景。

- TensorFlow、Keras: 适合深度学习场景。

3. 数据可视化工具

- Tableau: 适合数据可视化需求。

- Power BI: 适合企业级的数据分析。

注意事项

- 数据质量是关键: 数据是模型的根基,无论多复杂的算法,垃圾数据输入都会导致垃圾输出。

- 模型可解释性: 在某些场景下(如金融、医疗),模型的可解释性非常重要。

- 持续迭代: 数据和业务需求会随着时间变化,模型也需要不断迭代和更新。

结语

构建一个有效的大数据模型是一个复杂而有趣的过程,需要结合业务需求、数据特征和算法选择,进行全面的思考和实践。通过明确业务目标、准备高质量的数据、选择合适的算法、优化模型性能,并最终将其部署到生产环境,你可以为企业创造巨大的价值。

希望本文能够为你提供一些有用的指导和启发。如果你有任何问题或想进一步探讨,请随时留言,我会尽力为你解答!