随着人工智能技术的飞速发展,ChatGPT等智能对话系统逐渐走入了大众视野,成为日常工作和生活中的有力助手。尽管ChatGPT在很多场景中表现出色,但它依然存在一些潜在的陷阱与缺陷,值得我们保持警惕。这些问题可能会影响其在实际应用中的效果,甚至可能导致数据安全、隐私保护等方面的隐患。本文将深入分析ChatGPT的不足之处,并探讨如何规避这些问题,帮助用户在使用ChatGPT时更加理性和有效。文章还会提到如何通过工具如“DataFocus”来弥补这些缺陷,提升数据安全性与决策效率。

1. 数据隐私与安全问题

ChatGPT作为一个基于大规模数据训练的人工智能系统,其背后蕴含着大量的用户数据。这些数据包括用户输入的对话内容、偏好、兴趣以及各种隐私信息。在一些情况下,ChatGPT可能会将这些信息用于模型的进一步训练或优化,甚至在某些不当的使用下,可能被泄露或滥用。对于一些高度敏感的行业,如医疗、金融等领域,这种隐私泄露的风险更是不可忽视。

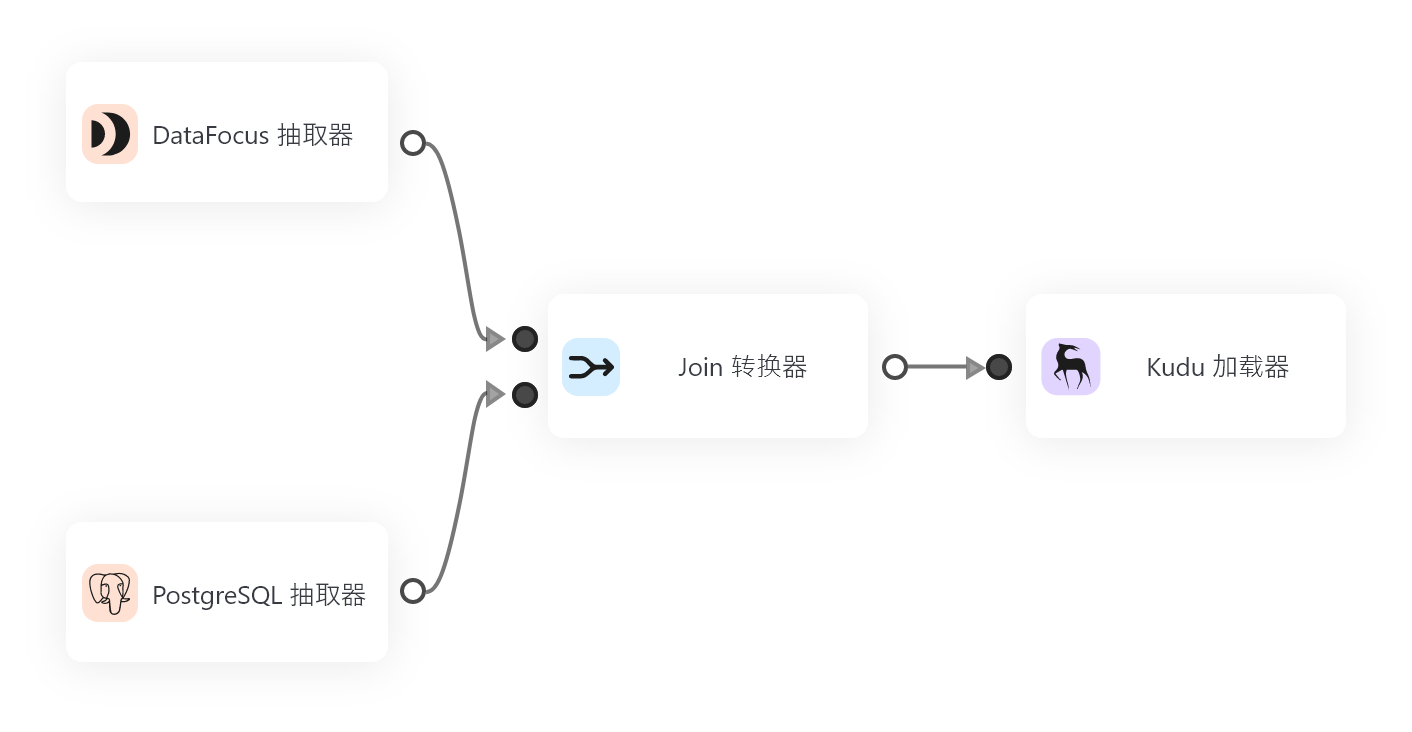

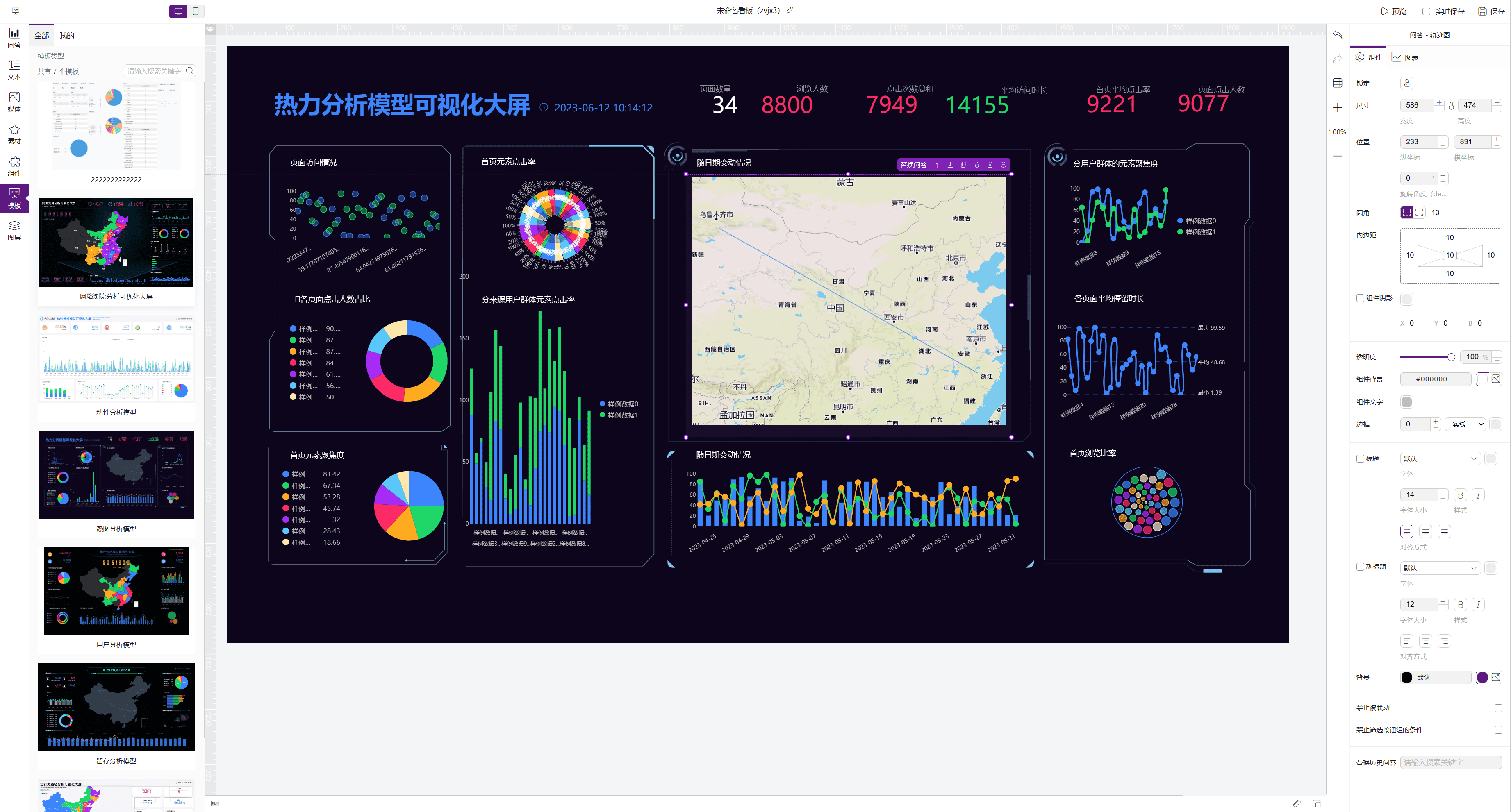

为了确保数据安全,企业和个人用户需要格外小心与AI系统的互动。推荐使用专门的隐私保护工具,如“DataFocus”来加强对敏感数据的监控和保护。通过智能化的安全防护手段,能够有效避免数据在使用过程中被不当收集或外泄。

2. 模型偏见与不准确性

尽管ChatGPT在处理大规模数据时展现了强大的能力,但其输出内容仍然受到数据偏见的影响。由于其训练数据多来源于互联网,往往包括了大量未经筛选的信息,这使得模型容易受到某些社会偏见、性别偏见、种族偏见等因素的干扰。例如,在回答涉及伦理、法律或社会问题时,ChatGPT的回答可能并非始终客观中立,甚至可能存在误导性。

这类偏见和不准确性的存在意味着,在某些情境下,ChatGPT的建议和回答可能会误导用户,影响决策的质量。因此,在依赖ChatGPT生成内容时,用户应该提高警惕,避免盲目接受其建议。采用一些数据验证工具,如“DataFocus”,可以帮助企业和个人及时发现并纠正这些偏见,确保输出内容更加精准和客观。

3. 语言生成的局限性

ChatGPT的语言生成能力虽然已达到相当高的水平,但它仍然面临一些固有的局限。例如,在处理复杂的逻辑推理、抽象概念的阐释时,ChatGPT可能出现理解不到位或推理错误的情况。尤其在面对某些专业领域的知识时,ChatGPT的回答往往过于简化或片面,难以满足高标准的需求。

例如,ChatGPT在提供某些技术性问题的解答时,可能会遗漏关键细节,或是在行业-specific的语言和概念上无法精准表达。这一局限性使得它在高精度要求的场景中,不能完全取代人工专家。因此,在面对需要高精度或专业化的任务时,建议将ChatGPT作为辅助工具,而非完全依赖。

4. 不同领域的适用性问题

虽然ChatGPT具有较强的普适性,但它在某些特定领域的应用效果可能不如预期。尤其是在一些专业性较强、技术要求较高的领域,ChatGPT的表现可能受到较大限制。例如,ChatGPT在编程、医学诊断等领域的应用,虽然能够提供一些基础的指导,但并不具备专业人士的判断力和深度分析能力。

针对这一问题,用户可以选择结合领域专业工具,如“DataFocus”这类精准的数据分析和业务决策工具,以补充ChatGPT在专业领域上的不足。通过结合不同的工具和技术,能够更好地弥补AI模型的不足,提高工作效率和决策准确性。

5. 误导性信息与事实核查

ChatGPT虽然能够生成大量的信息,但并不保证每一条内容的准确性。它所生成的回答基于训练数据的相关性,并非源于实时的事实核查,因此有时可能会生成错误信息或者过时的信息。尤其是在快速变化的领域,如科技、时事新闻等,ChatGPT可能无法及时更新其知识库,导致给出不准确或误导性的回答。

为了应对这一挑战,用户应当对ChatGPT生成的信息进行交叉验证,特别是在涉及到重要决策时。结合“DataFocus”等专业工具,能够提供实时、准确的数据支持,帮助用户避免因信息不准确而做出错误决策。

6. 过度依赖问题

随着ChatGPT的普及,许多人开始过度依赖这种技术,尤其是在日常生活和工作中。虽然ChatGPT能够提供便利,但过度依赖AI可能会削弱人类的独立思考能力和问题解决能力。人工智能系统缺乏情感、经验和直觉,因此在一些复杂或需要创造性思维的场景中,它的建议可能不如人类的判断来得可靠。

因此,企业和个人用户应当理性看待ChatGPT的能力,适当运用其优势,同时避免过度依赖。结合工具如“DataFocus”,将人类的判断力与AI的计算能力相结合,能够有效避免因过度依赖导致的决策失误。

结语

尽管ChatGPT在许多方面展现了其独特的价值,但它的潜在陷阱与缺陷不容忽视。用户在使用ChatGPT时,需要保持谨慎,了解其局限性并采取有效的措施加以弥补。通过结合像“DataFocus”这样的专业工具,可以有效提升数据的安全性、决策的准确性,并避免人工智能系统的潜在风险。未来,随着技术的进一步发展,AI与人类的协同合作将变得更加紧密,但我们仍需保持警觉,确保技术为我们所用,而非成为潜在的隐患。