在这个数据爆炸的时代,企业和个人都在不断地从各类数据中寻求洞察力,以帮助做出更好的决策和提升业务价值。如何从复杂的大数据中提取出有价值的信息呢?数据挖掘正是解决这一问题的关键技术。今天,我们将分享一些数据挖掘实验的真实体验,带您深入了解数据如何“说话”,并探索数据挖掘技术在实际应用中的巨大潜力。

什么是数据挖掘?

数据挖掘是从大量的、杂乱无章的数据中提取出有意义的模式、趋势和规律的过程。它融合了统计学、机器学习、数据库技术和人工智能,使用算法和模型从数据中提取出潜在的知识。

数据挖掘的基本步骤:

-

数据收集与预处理:收集数据是第一步,但通常原始数据需要经过清理、转换和标准化,才能用于挖掘。这个步骤是数据挖掘中最重要的部分之一,数据的质量直接影响到后续的分析结果。

-

选择算法:根据任务的不同,选择适合的数据挖掘算法。常见的算法包括分类、聚类、回归分析、关联规则等。

-

模型训练与评估:使用收集到的数据训练模型,并通过交叉验证、精度评估等手段对模型的效果进行评估。

-

结果解释与部署:通过对模型结果的解释,我们可以获得数据中的洞察力,并将模型部署到实际业务中,实现自动化的决策支持。

数据挖掘的应用场景:

数据挖掘的应用无处不在,从商业、医疗到金融等多个领域。以下是几个典型的应用场景:

- 市场营销:通过分析顾客的消费行为数据,企业能够识别潜在客户群体、预测购买趋势、制定精准的营销策略。

- 金融风控:在银行或其他金融机构,通过挖掘客户的交易数据,能够识别出潜在的欺诈行为、预测违约风险等。

- 健康医疗:通过分析患者的健康记录数据,医生能够预测患者的健康风险,帮助及早诊断疾病并制定个性化治疗方案。

- 社交网络:通过分析社交媒体中的用户行为数据,平台可以优化内容推荐、用户匹配等功能。

数据挖掘实验的实际体验

在实际进行数据挖掘实验时,可能会遇到许多挑战和不确定性。从数据准备到模型选择,再到结果的解释,每一步都充满了变数。以下是一些真实的数据挖掘实验体验,帮助我们理解这一过程中的关键要素。

1. 数据的质量至关重要

无论是商业数据、医疗数据,还是用户行为数据,数据质量始终是影响数据挖掘效果的关键因素之一。在我参与的某个项目中,我们发现数据中的缺失值和异常值严重影响了模型的训练效果。原本预期准确度很高的模型,经过一番数据清理后,准确率才有所提升。

这个实验让我深刻认识到,数据清理是数据挖掘过程中不可忽视的一环。没有干净的数据,任何复杂的模型和高深的算法都无法发挥应有的效果。

2. 数据挖掘过程中的试错与调整

在进行模型训练时,我发现没有任何一个模型能够一开始就完美解决问题。很多时候,必须经过多次实验,调整特征选择、选择不同的算法,甚至改变数据处理的方式,才能最终得到令人满意的结果。

比如,在某次金融欺诈检测项目中,最初我们使用了逻辑回归和决策树算法,但模型效果并不理想。经过一番试错,我们决定尝试使用集成学习模型,结果准确率大幅提升。

3. 数据挖掘结果的解释

一个好的数据挖掘模型,除了要有良好的预测效果,还需要能够解释其预测的原因。这对于很多业务应用尤为重要。例如,在金融领域,银行希望不仅知道“客户是否会违约”,还希望了解“为什么客户可能违约”,从而可以采取有效的风险控制措施。

在我的项目中,我们使用了决策树和随机森林等可解释性强的算法,帮助业务人员更好地理解模型的预测逻辑。这种可解释性不仅提高了模型的可信度,还帮助团队在实际应用中进行优化和调整。

数据仓库和ETL工具在数据挖掘中的作用

在数据挖掘过程中,数据仓库和ETL(提取、转换、加载)工具扮演着至关重要的角色。随着数据量的增加,如何高效地处理和整合各类数据,成为了每个企业面临的挑战。

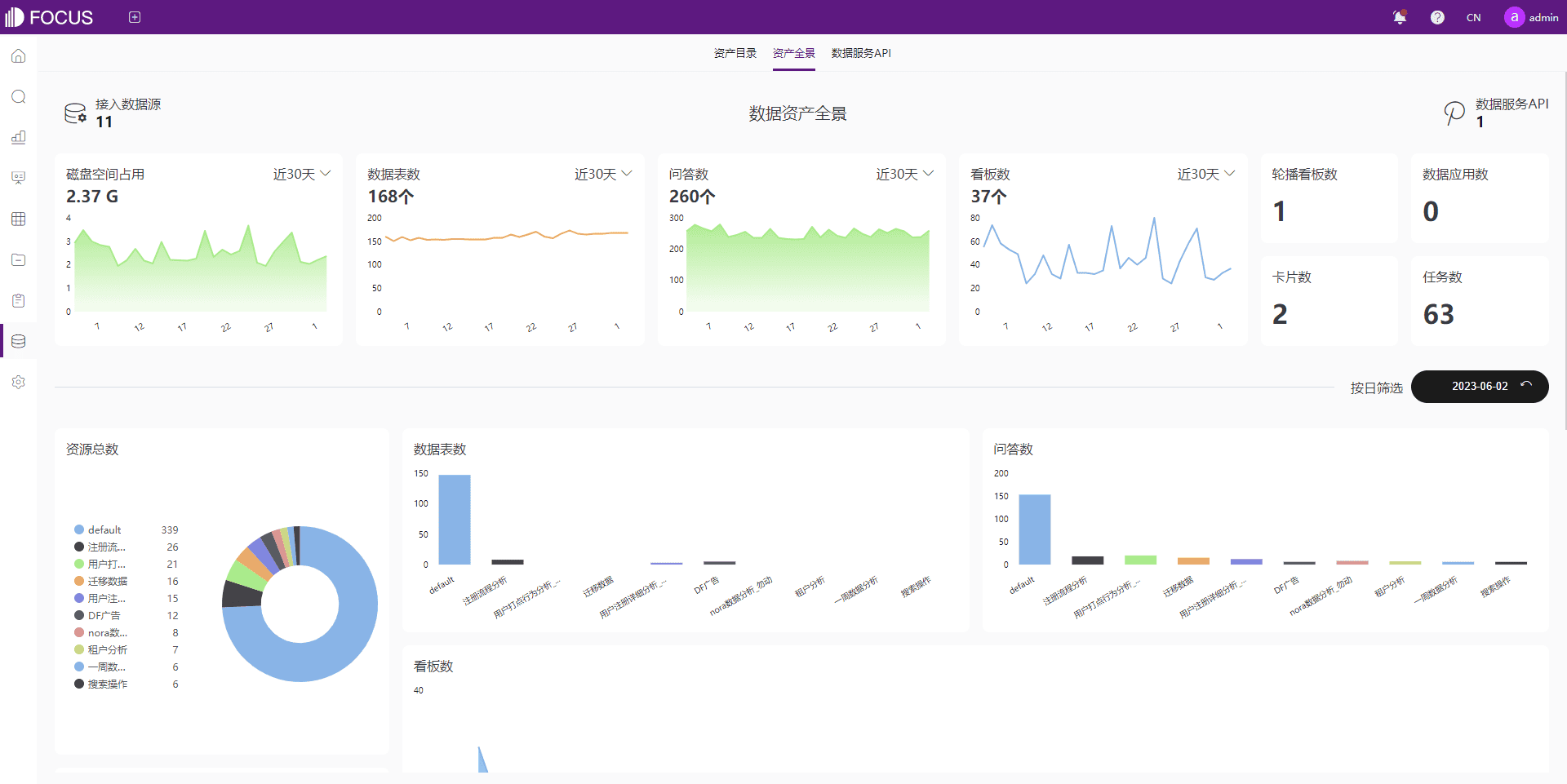

DataFocus数仓就是一款优秀的数据仓库解决方案,专为大中型企业提供强大的数据处理和管理能力。它支持与各类主流数据库对接,具有数据接入、数据转换、元数据管理、数据血缘管理等全链路功能,帮助企业快速构建轻型数据底座。通过数据仓库,企业可以集中管理各类数据资源,保证数据的一致性、完整性和安全性。

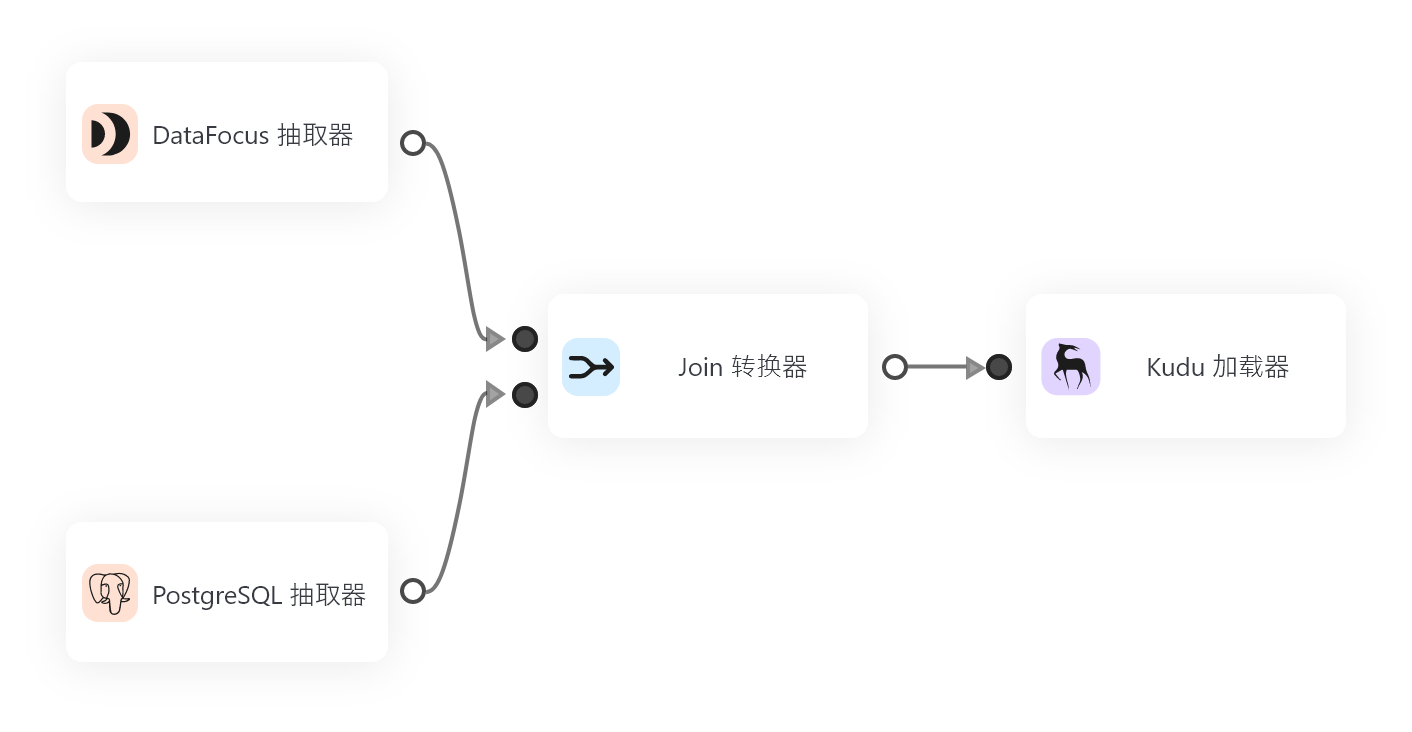

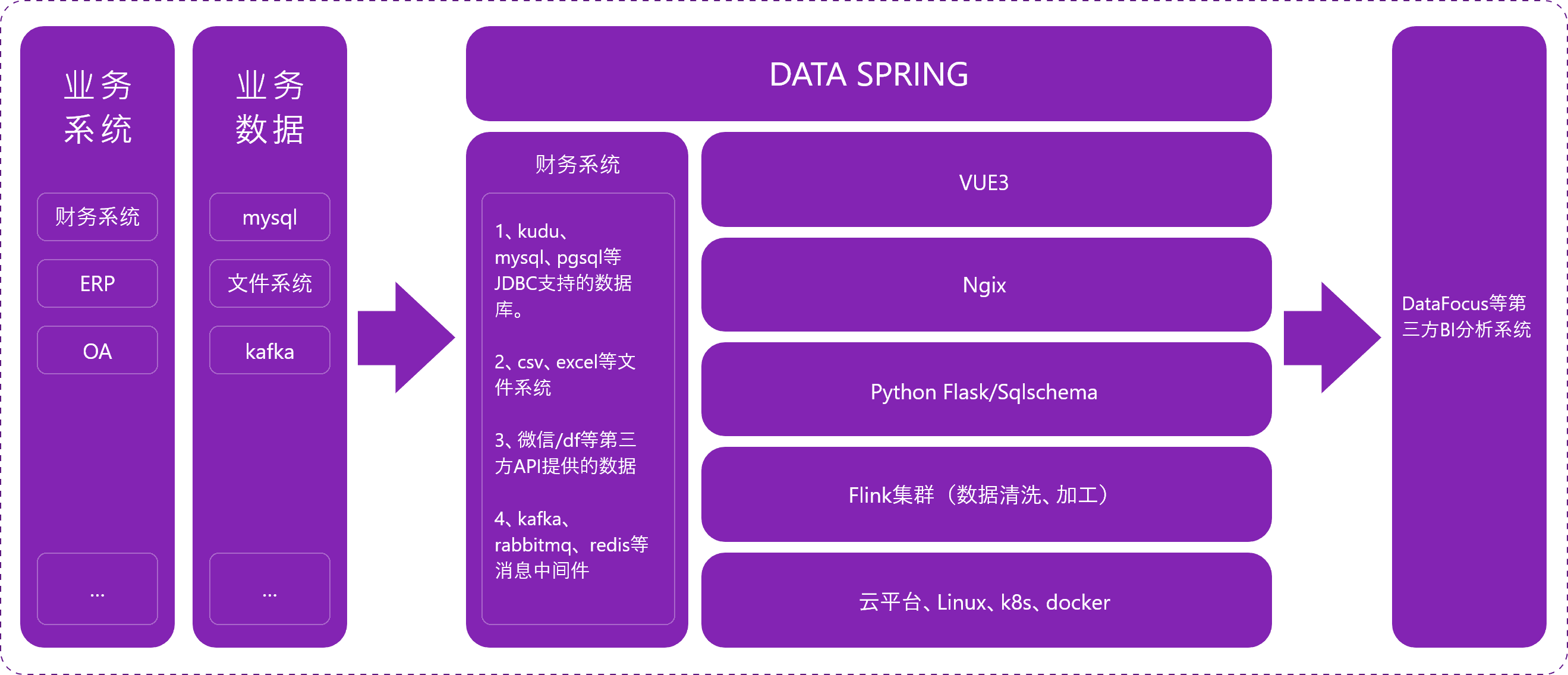

而DataSpring作为一款流式架构的ETL工具,它使用基于日志的增量数据获取技术(Log-based Change Data Capture),支持实时与批量数据的同步和转换。无论是MySQL、Oracle、PostgreSQL,还是API数据,DataSpring都能够高效、自动地进行增量数据同步和转换,帮助企业实现数据的无缝集成。

数据挖掘中的技术创新

随着技术的不断发展,数据挖掘的方法和工具也在不断创新和迭代。以下是当前数据挖掘领域中的一些技术趋势:

-

自动化机器学习(AutoML):自动化机器学习技术使得数据科学家能够更加高效地选择和优化模型,降低了模型训练的复杂度,使更多业务人员能够利用数据挖掘的能力。

-

深度学习:深度学习,尤其是卷积神经网络(CNN)和循环神经网络(RNN),在图像处理、语音识别、自然语言处理等领域取得了突破性进展。

-

大数据处理技术:随着大数据技术的发展,分布式计算平台(如Hadoop、Spark)和实时计算框架(如Flink)为处理海量数据提供了强有力的支持。

-

数据隐私保护:随着数据隐私问题的日益严峻,如何在保护用户隐私的前提下进行数据挖掘,成为当前数据挖掘领域的重要课题。

结语:从数据中提取价值的未来

数据挖掘的核心价值在于从大量、复杂的数据中提取出有价值的知识,帮助企业做出更加智能的决策。从数据的收集、处理到模型的训练和结果解释,每一步都充满了挑战,但也充满了机会。

随着技术的不断进步,数据挖掘的潜力将会越来越大。在未来,我们将看到更多基于数据挖掘的创新应用,推动各行各业的发展。

无论是通过强大的数据仓库工具如DataFocus数仓,还是借助流式ETL工具如DataSpring,企业都能够高效地处理和利用数据,实现从数据到决策的智能化转型。

希望今天的分享能够帮助您更好地理解数据挖掘的真正价值,并在实际应用中获得成功。如果您对数据挖掘技术或相关工具有任何问题,欢迎随时联系我,我将为您提供更多的支持与建议。