打造完美数据治理体系的关键要素

在数字化转型的浪潮中,企业面临着日益复杂的数据挑战。如何高效、精准地管理海量数据,确保数据质量和合规性,成为每个企业在追求智能化的过程中不可回避的问题。数据治理体系作为确保数据管理质量、可靠性和安全性的重要框架,已经成为现代企业信息化建设的核心组成部分。本文将深入探讨打造完美数据治理体系的关键要素,帮助企业通过合理的规划和工具选择,实现数据的高效治理和应用。

数据治理不仅仅是一个技术层面的任务,它涵盖了数据的采集、存储、处理、使用和安全等多个方面。一个完善的数据治理体系能够确保数据的准确性、一致性和可访问性,为企业的决策支持、业务分析和创新提供强有力的支持。随着大数据、人工智能和云计算的快速发展,企业需要在数据治理过程中不断应对新的挑战和机遇。今天,我们将聚焦于数据治理的几个关键要素,帮助企业在复杂的环境中打造一个强大且高效的数据治理体系。

1. 数据质量管理

数据质量管理是数据治理的核心要素之一。企业在进行数据采集、存储和使用时,必须确保数据的准确性、一致性、完整性和时效性。劣质数据不仅会导致错误决策,还可能带来巨大的业务风险。为了实现高质量的数据管理,企业必须建立数据清洗和验证的流程,利用自动化工具进行数据校验和清理,确保数据质量始终符合标准。

例如,采用像 DataFocus数仓 这样的数据平台,企业可以实现从数据接入、处理、管理到血缘分析的全链路功能,确保数据在全生命周期中的质量。通过集成元数据管理和数据资产管理,企业能够清晰掌握每一条数据的来源和变更过程,进一步提高数据质量控制的精度和透明度。

2. 数据安全与隐私保护

数据安全与隐私保护是数据治理体系中不可忽视的另一个重要环节。随着数据泄露事件频发,企业越来越需要加强对敏感数据的保护,以防止数据被滥用或未经授权的访问。除了物理和网络安全措施,企业还需要通过严格的权限管理、加密技术和数据脱敏等手段,确保数据在存储和传输过程中得到有效保护。

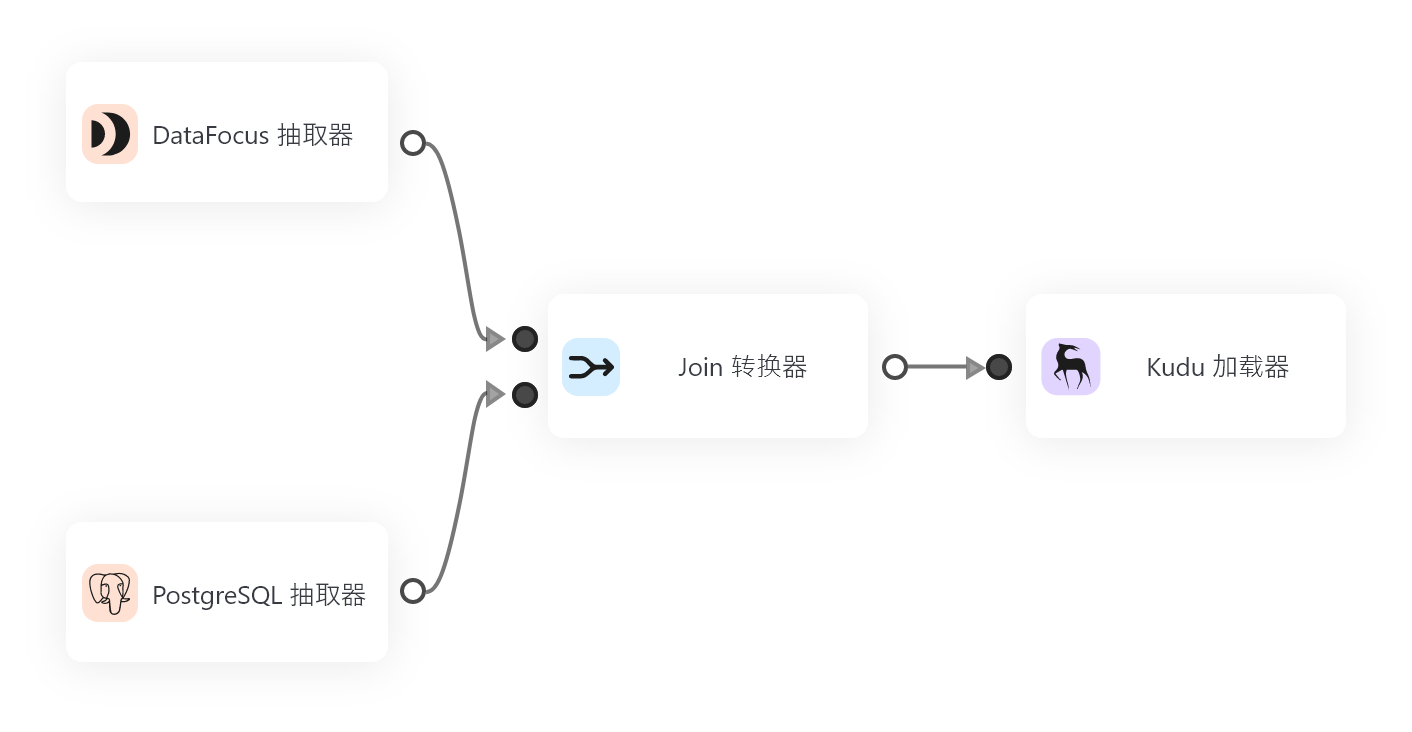

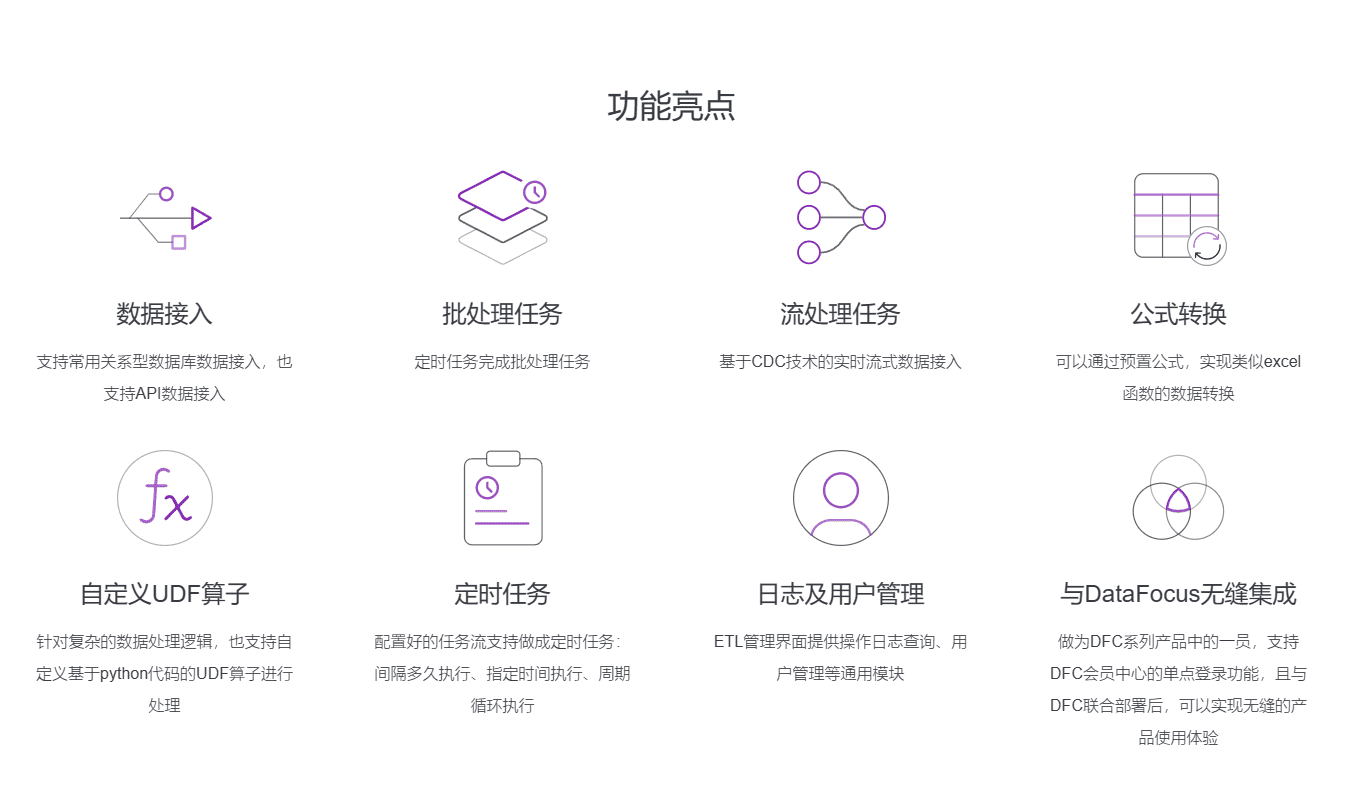

对于需要进行大规模数据迁移和处理的企业来说,选择一款支持数据安全和合规的工具尤为重要。 DataSpring 作为一款基于流式架构的ETL工具,采用最新的增量数据获取技术(Log-based Change Data Capture),不仅能够高效处理异构数据,还能确保在数据同步和转换过程中保持高水平的安全性,避免数据泄露的风险。

3. 数据一致性与集成

在数据治理过程中,数据的一致性和集成是至关重要的。许多企业面临的数据存储环境十分复杂,数据来自不同的系统和平台,如何将这些异构数据进行集成并保持一致性,成为了数据治理的难题。为此,企业必须采用适当的数据集成策略,如数据仓库建设、数据湖以及实时数据流的处理,确保不同数据源之间的数据能够流畅互通。

DataFocus数仓 提供了强大的数据集成能力,不仅支持对接各种主流数据库,还能够通过中间表处理、数据血缘管理等功能,确保数据源之间的一致性和透明度。通过自动化的数据流转和集成,企业可以在各类数据源之间建立统一的数据模型,简化数据的整合和使用过程。

4. 数据血缘与元数据管理

数据血缘与元数据管理是数据治理体系中的另一个关键要素。数据血缘图能够帮助企业追踪数据的流动和变更,确保每一项数据都能追溯到源头,并能反映数据的转换过程。这对于发现数据质量问题、保证数据准确性和合规性,以及进行审计和审查都至关重要。

借助 DataFocus数仓 的数据血缘管理功能,企业可以准确追踪数据在系统中的流动路径,清晰展示数据的来源和去向。这对于大中型企业尤其重要,因为它们通常需要处理庞大的数据量,且不同的业务部门和系统对数据有不同的需求。

5. 实时数据处理与监控

在当今快速变化的商业环境中,企业越来越依赖于实时数据来做出决策。因此,实时数据处理和监控成为数据治理的重要组成部分。无论是处理传感器数据、用户行为数据,还是业务运营数据,企业都需要能够在数据生成的同时对其进行实时分析和处理,确保能够快速响应市场变化和业务需求。

DataSpring 作为一款支持流式架构的ETL工具,能够实时同步和转换数据,确保企业在不同系统之间的实时数据流动。其强大的增量同步能力和日志驱动的数据捕捉技术,使得企业能够高效、准确地处理大规模数据流,并在实时监控中及时发现潜在问题。

6. 数据生命周期管理

数据生命周期管理是数据治理的另一项基础性工作,涉及到数据的生成、存储、使用、归档和销毁等各个阶段。企业需要根据数据的价值和使用频率,合理安排数据的存储和访问策略。数据的删除和销毁也应遵循严格的政策,以确保不必要的数据不会占用资源,且不违反数据保护法律法规。

通过高效的数据生命周期管理,企业可以降低存储成本、提高数据使用效率,并确保数据管理的合规性。通过 DataFocus数仓 和 DataSpring 等工具的配合使用,企业能够在全链路中实现数据的规范化管理,确保每一条数据都得到合理的存储和使用。

7. 数据治理的自动化与智能化

随着数据量的剧增和处理复杂度的提高,手工操作已无法满足企业对数据治理的需求。因此,自动化和智能化的工具成为了实现高效数据治理的必然选择。通过机器学习、人工智能和自动化工作流,企业可以在数据治理过程中实现更多的自动化操作,从数据清理、分类到合规性检查等,都能通过智能化工具来完成。

结合 DataSpring 的自动化增量同步功能和 DataFocus数仓 的全链路数据治理能力,企业可以实现更高效的数据治理过程,减少人为操作错误,提高治理效率。

结语

打造一个完善的数据治理体系是一个复杂而系统的过程,涉及到多个方面的工作。数据质量管理、数据安全、数据集成、数据血缘、实时数据处理以及智能化治理等要素,都在其中发挥着关键作用。通过采用如 DataFocus数仓 和 DataSpring 这类高效的工具,企业能够在数据治理的每个环节中实现自动化、智能化和高效化管理,从而为业务决策提供坚实的数据支撑。随着数据量的不断增长,企业必须持续优化和完善其数据治理体系,以确保在这个数据驱动的时代中保持竞争力和合规性。