如何高效进行数据清洗加工?

在现代数据驱动的商业环境中,数据清洗和加工已成为确保数据质量和可用性的关键步骤。无论是对企业运营数据的分析,还是对市场趋势的预测,数据的准确性和一致性都是至关重要的。本文将深入探讨高效进行数据清洗和加工的方法,从数据清洗的基本概念到如何利用先进的工具提升效率,确保数据在整个生命周期中保持高质量。我们将具体介绍如何通过高效的数据清洗流程提升数据的准确性、减少冗余数据,并最大化数据的利用价值,特别是在面对庞大复杂的数据集时,如何借助智能工具如DataFocus数仓与DataSpring来优化这一过程。

什么是数据清洗加工?

数据清洗加工是数据预处理中的重要步骤,旨在消除数据中的错误、冗余或不一致性,以确保后续分析的准确性。通过清洗,数据能够以更高的质量支持各种业务需求,包括数据分析、机器学习训练等。而数据加工则是对清洗后的数据进行进一步处理,形成可以直接用于业务决策的标准化格式或模型。这一过程不仅提高了数据的质量,也提高了数据处理的效率。

数据清洗的常见问题

在进行数据清洗时,首先要识别并解决一些常见的数据问题:

-

缺失数据:在数据采集过程中,由于系统故障或输入错误,可能会产生缺失值。缺失的数据如果不处理,会影响分析结果的准确性。常见的处理方法包括填充缺失值、删除含缺失值的记录或利用模型预测缺失值。

-

重复数据:重复数据不仅浪费存储空间,还可能导致分析结果出现偏差。通过数据去重,确保每条数据记录的唯一性是清洗的关键步骤。

-

异常值:在数据采集过程中,难免会产生一些异常值。异常值如果不及时清理,可能会影响数据分析模型的性能。通过设置阈值、统计方法等手段检测和处理异常数据是清洗的一部分。

-

不一致的数据格式:不同来源的数据往往格式不同,尤其是多系统、多渠道的数据集。统一数据格式,例如日期格式的转换或单位标准化,是确保数据质量的重要环节。

-

噪声数据:噪声数据通常指无用或无关的数据,它们对分析没有任何帮助。通过合适的规则对数据进行筛选和过滤,可以有效去除这些噪声。

数据加工的关键步骤

数据清洗完成后,下一步就是数据加工,主要包括:

-

数据转换:将数据从原始格式转换为适合分析或展示的结构化格式。常见的转换包括数据类型转换、格式化处理、时间戳标准化等。

-

数据整合:在大部分业务场景中,数据往往来自多个系统或平台。通过数据集成技术,可以将来自不同来源的数据进行整合,形成一个统一的视图。

-

数据规范化:为了便于数据分析和模型训练,通常需要对数据进行规范化处理。例如,将数值型特征标准化,或者通过归一化处理将数据映射到同一尺度。

-

数据建模:对于某些业务应用,数据清洗和加工后,还需要进行一定的建模。这包括数据聚合、特征工程等步骤,用于进一步提升数据的分析价值。

高效的数据清洗加工如何实现?

数据清洗和加工并非一成不变的过程,需要根据不同的数据场景和需求,灵活采用各种方法与工具来提升效率。以下是一些提高数据清洗加工效率的关键实践。

1. 自动化数据清洗流程

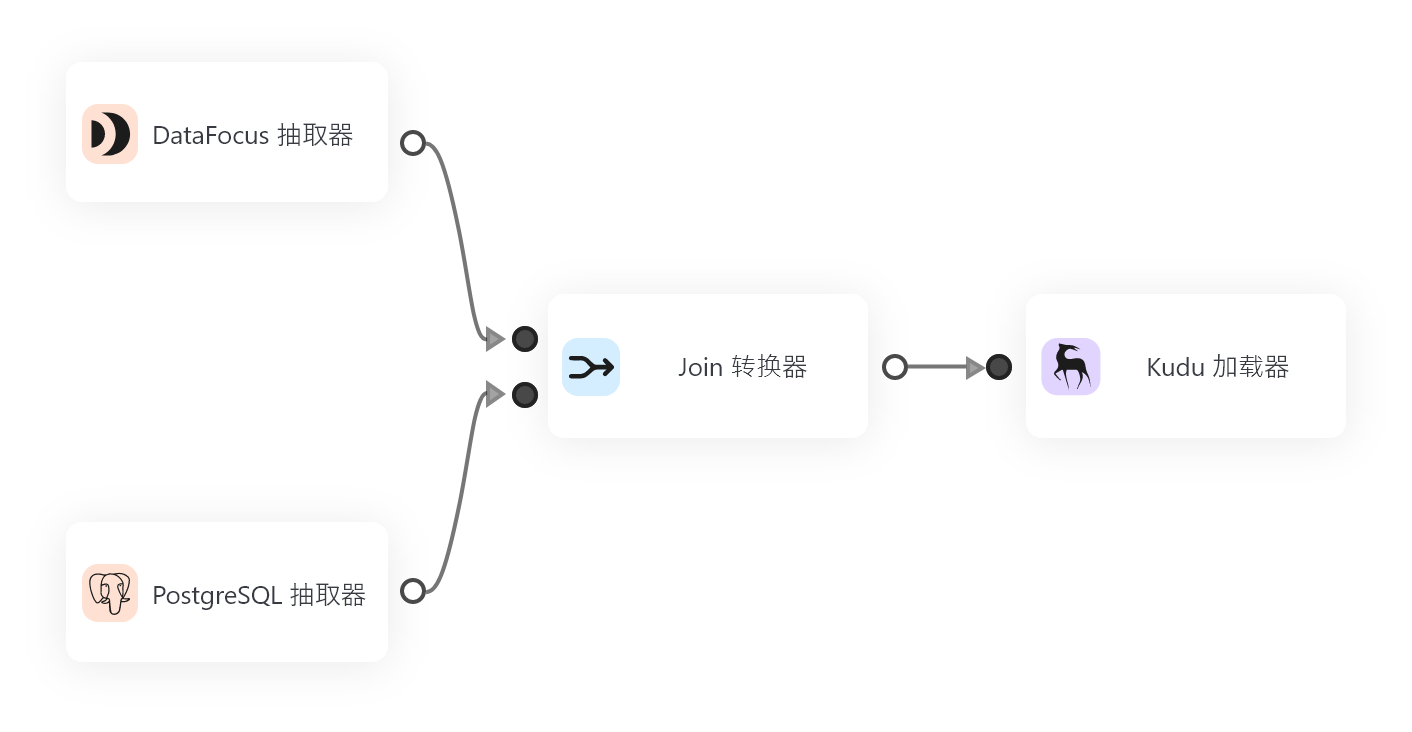

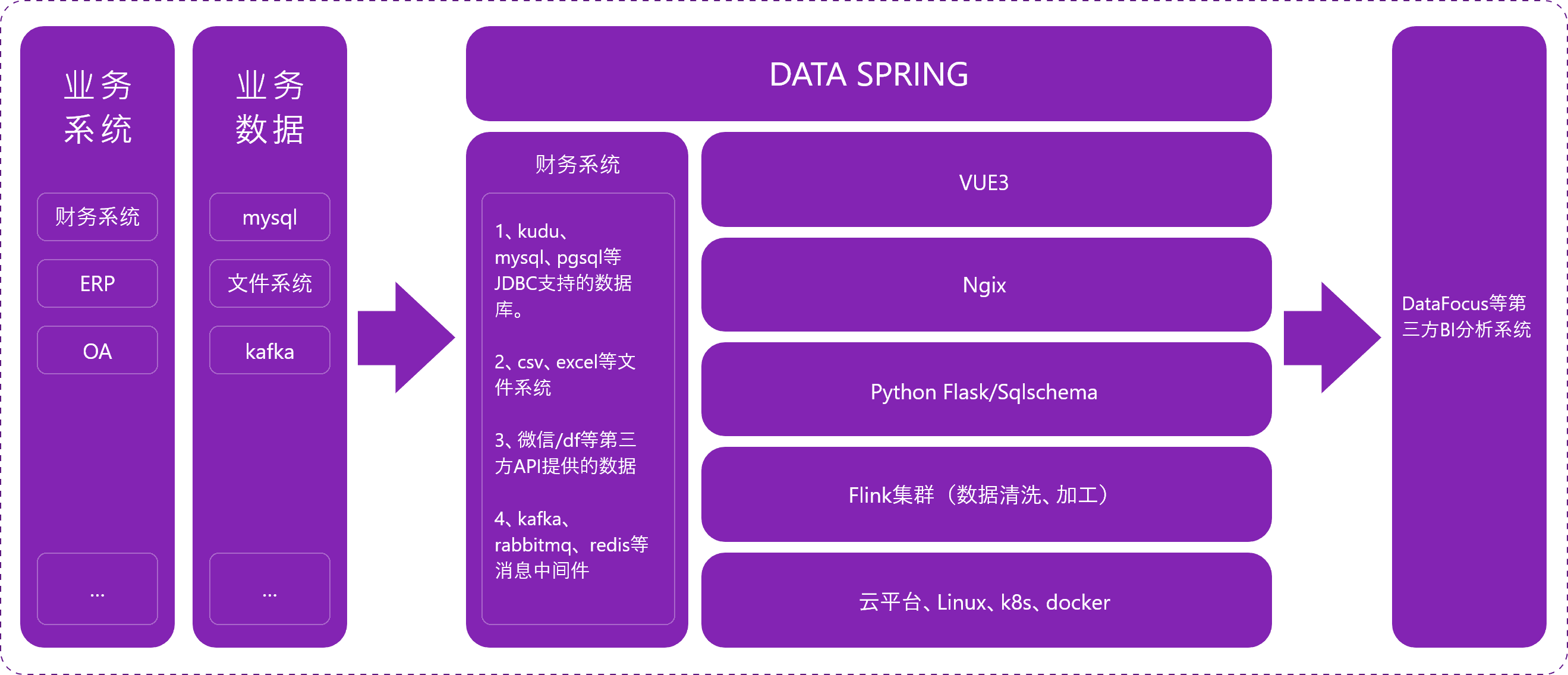

传统的数据清洗往往依赖人工判断和手动操作,这不仅耗时,还容易产生人为错误。借助自动化工具,可以显著提升数据清洗的效率。现代的ETL工具,如 DataSpring,采用基于日志的增量数据捕获技术(Log-based Change Data Capture),支持自动化的增量同步和转换。这种技术可以在数据变化时自动捕捉变化并进行处理,减少了人工介入,并确保数据处理的实时性与准确性。

2. 数据血缘管理

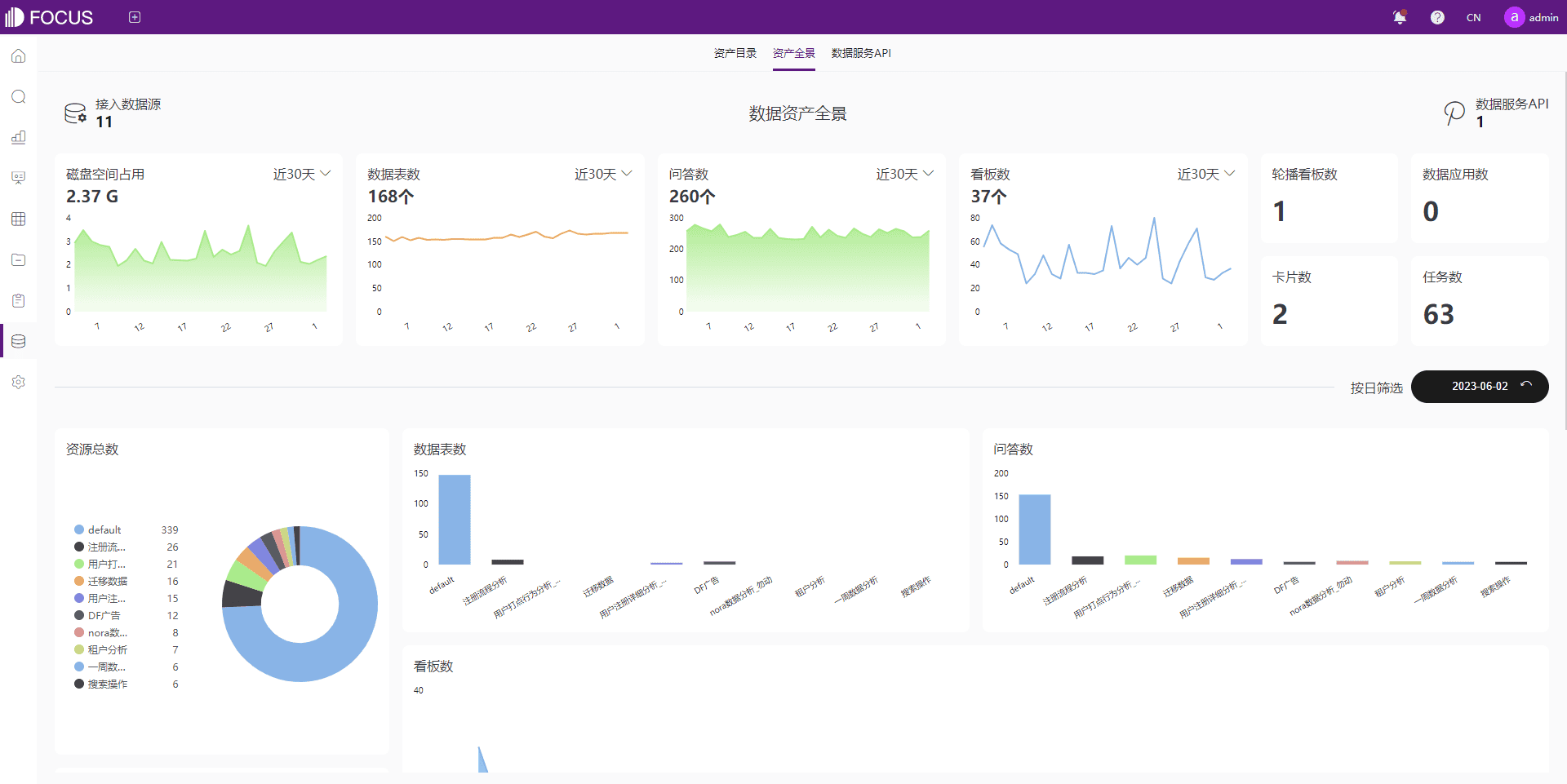

数据血缘管理是数据处理流程中的重要环节,它能够追溯数据的来源、流转和变动。通过数据血缘管理,能够清晰地了解每一条数据的生命周期,从而提高数据质量监控和问题定位的效率。 DataFocus数仓 提供了强大的数据血缘管理功能,可以全面掌控数据流动和变化,确保数据的透明性与可信度。

3. 灵活的数据连接与集成

随着企业信息化建设的推进,数据来源日益复杂,涉及的系统种类繁多。无论是关系型数据库、非关系型数据库,还是外部API接口,数据清洗加工都需要支持多种数据源的灵活接入。工具如 DataFocus数仓 可以与各种主流数据库(如 Oracle、MySQL、SQL Server、PostgreSQL 等)无缝对接,帮助企业在数据接入、处理和集成过程中更加高效。

4. 实时数据处理

随着业务需求的变化,越来越多的场景要求能够进行实时数据处理,尤其是在金融、电商等领域。 DataSpring 提供了强大的实时数据处理能力,可以同步处理实时与批量数据,确保数据流的及时性和准确性。DataSpring还支持自动化的语义映射构建,这使得不同数据源之间的整合变得更加简单、快速。

5. 数据质量监控与报告

高效的数据清洗和加工需要持续的质量监控。通过设置数据质量标准和自动化监控机制,企业可以实时跟踪数据质量状况,并及时发现并解决潜在问题。数据质量报告可以帮助数据团队了解清洗过程中出现的具体问题,并据此优化数据处理流程。

总结

数据清洗加工是大数据时代确保数据质量的关键环节。无论是数据的清洗、转换还是整合,都需要高度的专业化处理。通过自动化工具、实时数据处理平台和数据血缘管理等技术手段,企业能够有效提升数据清洗加工的效率和质量。借助像 DataFocus数仓 和 DataSpring 这样的先进工具,企业能够快速、准确地处理海量数据,帮助决策者在复杂的数据环境中做出更精准的业务决策。随着数据技术的不断进步,未来的数据清洗和加工将更加智能化、自动化,成为推动企业数字化转型的重要力量。