在数字化转型的浪潮中,企业对数据的依赖与日俱增,高效构建数据仓库和ETL流程成为了提升决策质量和运营效率的关键。许多企业在搭建数据平台时,往往面临数据碎片化、处理效率低下以及复杂的维护挑战。本文将详细探讨如何高效地构建数据仓库和ETL流程,帮助企业优化数据处理流畅性,并确保数据的可靠性与高效性。我们将介绍适用于大中型企业的解决方案——DataFocus,如何通过其全链路功能,助力企业快速构建轻型数据底座,提升数据资产管理效率。

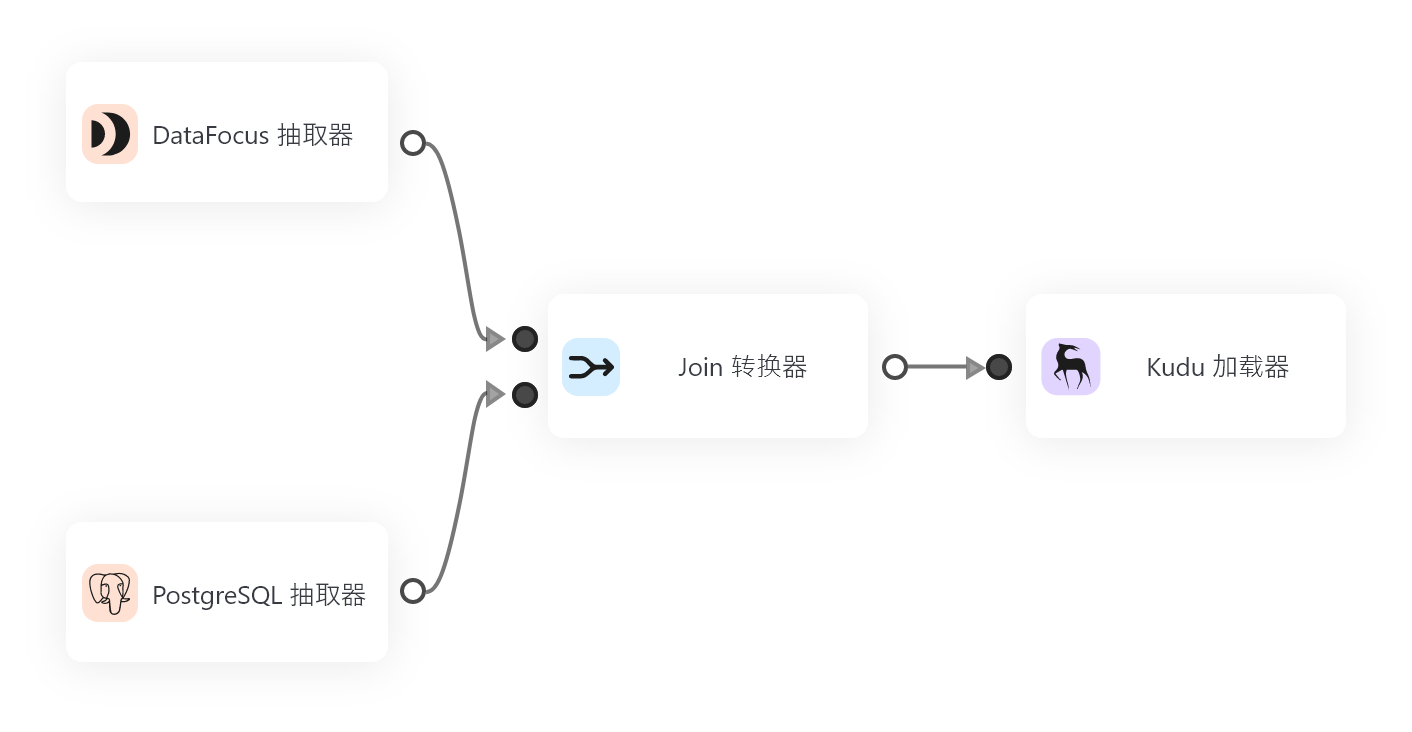

在构建数据仓库的过程中,首先需要明确数据的源头和目标,以及数据仓库的架构。传统的ETL(提取、转换、加载)流程通常需要对来自不同数据源的数据进行整合,确保数据的准确性和一致性。高效的ETL流程能够简化数据流动,减少中间环节的复杂性,并保证数据的高质量输入到数据仓库中。

一个高效的数据仓库不仅需要强大的数据存储能力,还要具备出色的数据处理能力。因此,ETL的设计至关重要。传统的ETL流程一般由三部分组成:数据提取(Extract),数据转换(Transform)和数据加载(Load)。数据提取是整个流程的起点,通常涉及从不同来源系统(如CRM、ERP等)提取数据。这些数据可能以多种格式存在,如结构化数据、半结构化数据甚至非结构化数据。为了确保数据的完整性和一致性,ETL工具需要具备强大的数据提取能力。

数据转换阶段则是ETL流程中的核心。该阶段主要进行数据清洗、数据规范化、格式转换以及各种逻辑处理。转换后的数据通常会被规范化成一个标准格式,方便后续的分析和查询。数据转换不仅仅是格式转换,更需要考虑到业务需求,确保数据能够满足特定分析场景的要求。这一环节对系统性能和计算能力的要求较高,因此选择合适的ETL工具是保证高效性的重要因素。

数据加载环节是ETL流程的终点。此阶段将处理好的数据导入到数据仓库中。数据加载的效率和精确度直接影响到数据仓库的整体性能。如果数据加载出现问题,整个数据仓库的准确性和可用性将受到严重影响。因此,合理的加载策略、批量加载与实时加载的平衡,都需要根据企业的实际需求来设计。

在实际的ETL流程中,数据质量的保障至关重要。企业应通过对数据进行全面的质量监控,及时发现和解决问题。除此之外,数据安全和合规性也是构建数据仓库时必须考虑的要素。随着数据的日益增多,如何管理和保护这些数据,如何保证数据在整个ETL流程中的流动性和完整性,成为了企业面临的一大挑战。

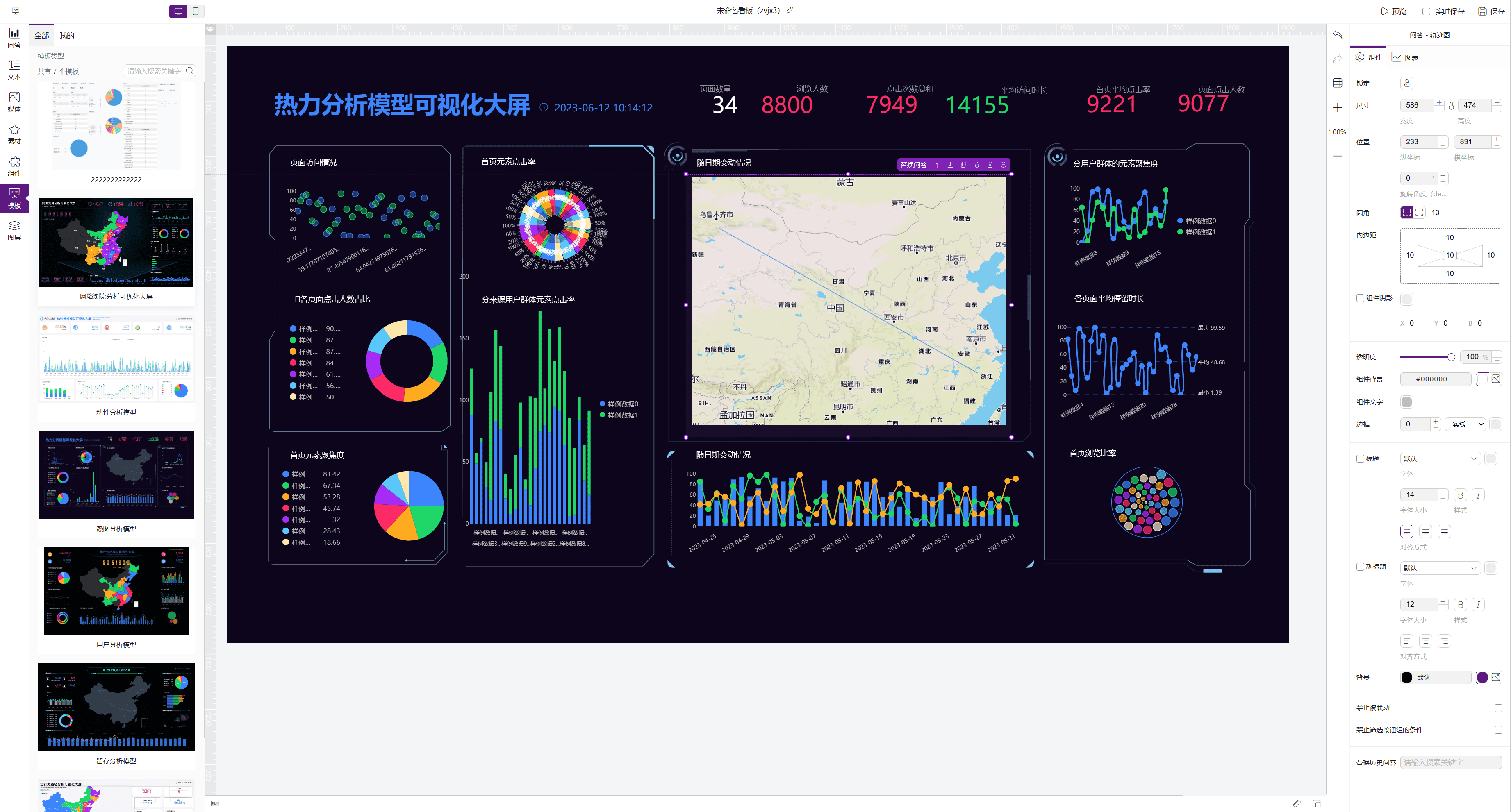

这时,像DataFocus这样的数据仓库解决方案便显得尤为重要。DataFocus不仅可以对接各型主流数据库,具备从数据接入、处理、到数据血缘管理、元数据管理等全链路功能,更具备出色的API管理能力,能够大幅提高企业数据处理的灵活性和效率。对于大中型企业而言,DataFocus能够帮助企业快速建设轻型数据底座,在保证数据质量与一致性的降低了技术架构的复杂度,使得数据流动更加顺畅,系统运行更加高效。

最终,企业在构建数据仓库和ETL流程时,应该充分考虑数据的来源、处理和存储,选择合适的工具和平台。借助强大的ETL工具以及成熟的数据仓库解决方案,企业能够确保数据的质量和完整性,同时提升决策效率和业务洞察力。DataFocus凭借其全链路功能和高效的数据管理能力,正是帮助企业实现数据资产管理目标的理想选择。