深度解析数据仓库的ETL优化策略

在数据驱动的时代,数据仓库已经成为企业决策支持和分析的核心。而ETL(Extract, Transform, Load)作为数据仓库中的关键环节,其优化对于提高数据处理效率、降低系统负荷、提升数据质量至关重要。本文将深度解析ETL优化策略,并结合当下主流的产品解决方案,探讨如何通过有效的ETL优化,提升企业数据仓库的整体性能,尤其是在大中型企业的数据处理和管理需求中,如何选择合适的工具和策略。

1. ETL优化的背景与重要性

随着数据量的持续增长,传统的ETL流程常常面临处理延迟高、资源消耗大、数据一致性差等问题。尤其是在面对多样化的数据源与复杂的数据转换需求时,ETL的性能瓶颈尤为突出。因此,优化ETL流程不仅能提升数据仓库的整体运行效率,还能显著改善数据处理的可扩展性和灵活性,从而支持更加及时和精准的商业决策。

ETL优化的目标是通过更高效的数据抽取、转换和加载过程,降低对计算资源的占用,提高系统的响应速度和处理能力,减少处理时间,保障数据的质量与一致性,最终为企业提供高效、可靠的数据支撑。

2. ETL优化的关键策略

2.1 数据抽取优化

数据抽取是ETL流程中的第一步,通常涉及从不同的源系统获取数据。数据源的多样性和分散性往往使得抽取过程复杂且低效。为了优化数据抽取,可以考虑以下策略:

- 增量抽取:与全量抽取相比,增量抽取只获取自上次抽取以来发生变化的数据,能够显著减少数据量,提高抽取速度,降低数据库负载。

- 并行抽取:对于多个数据源,可以采用并行抽取技术,避免传统的串行抽取造成的时间瓶颈。

- 缓存机制:对于频繁访问的数据,可以利用缓存技术,避免每次抽取时都向源系统发送请求,减少不必要的操作。

2.2 数据转换优化

数据转换是ETL中的核心环节,主要包括数据清洗、格式转换、计算和聚合等操作。由于转换过程复杂且资源消耗大,如何优化数据转换成为提升ETL效率的关键。

- 分布式计算:采用分布式计算框架(如Apache Spark、Flink等)可以将转换任务拆分到多个节点上并行处理,从而大大提高转换速度。

- 优化转换逻辑:通过精简转换逻辑、减少不必要的计算,避免重复操作,有助于提升处理效率。尤其是针对复杂的聚合和联接操作,优化算法能显著降低转换过程中的计算开销。

- 批处理与流处理结合:将批处理和流处理相结合,可以同时满足大规模数据处理和实时数据处理的需求。在对实时数据要求较高的场景下,流式处理尤为重要。

2.3 数据加载优化

数据加载是ETL过程的最后一步,负责将数据加载到目标数据仓库中。加载效率的高低直接影响整个ETL流程的运行效率。优化数据加载可以采取以下方法:

- 批量加载:批量加载能够在一次操作中处理大量数据,减少多次单条记录插入的开销。对于大规模数据,采用批量处理方式显著提高了加载效率。

- 分区加载:通过数据分区技术,可以将大表分割成多个小表,针对不同分区进行并行加载,避免因数据量过大而造成的加载延迟。

- 数据压缩:压缩技术可以减少数据在加载过程中的存储空间,从而加快数据传输和加载速度。压缩后的数据不仅能减少存储成本,还能提高加载效率。

2.4 数据质量监控与错误处理

数据质量问题常常是导致ETL流程效率低下的根本原因之一。为确保ETL流程顺畅运行,必须加强数据质量管理和错误处理机制。

- 数据清洗:在ETL过程中,尤其是数据转换阶段,数据清洗至关重要。去除无效数据、填补缺失值、标准化数据格式是提高数据质量的基础。

- 错误处理机制:确保ETL过程中的异常得到及时反馈,并有针对性的处理方式。可以通过设置监控机制,对ETL过程中的错误进行实时监控,并触发相应的报警机制,确保数据准确性和及时性。

3. 企业如何选择合适的ETL工具

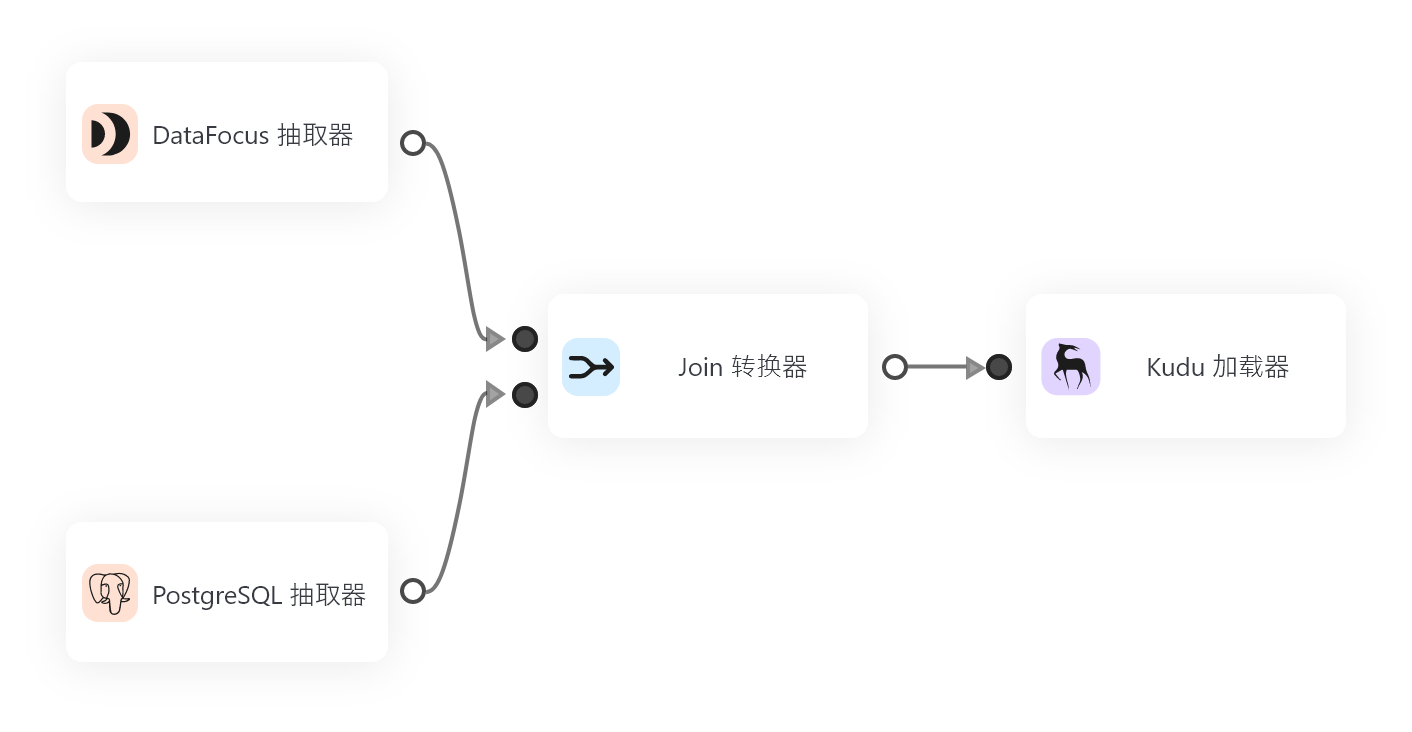

虽然传统的ETL工具(如Informatica、Talend等)在许多大企业中得到了广泛应用,但随着技术的进步和业务需求的变化,企业对于ETL工具的要求也越来越高。灵活性、扩展性和易用性是企业选择ETL工具时需要重点考虑的因素。以DataFocus为例,这款数仓解决方案具备了全面的ETL优化功能,能够支持从数据接入、转换、加载、到数据管理的全流程管理。

DataFocus能够对接各类主流数据库,支持从数据接入到数据血缘管理的全链路功能,使企业能够灵活应对多种数据源的接入需求。在大规模数据处理和复杂转换场景下,DataFocus还支持高效的数据处理,能够通过分布式计算优化数据转换过程,提升ETL效率。DataFocus的元数据管理功能,有助于实现数据的自动化管理和监控,确保数据质量和一致性。

4. 总结

在当今数据量激增和业务需求不断变化的背景下,优化ETL流程对于企业的数据仓库性能至关重要。通过增量抽取、并行处理、批量加载等策略,可以显著提升ETL效率,减少资源浪费和处理延迟。结合强大的ETL工具,如DataFocus,企业能够在确保数据质量的提升数据仓库的整体性能,为业务决策提供及时、准确的数据支持。

专业的ETL优化不仅仅是提高处理速度,更是保障数据质量和可扩展性的关键。在选择合适的ETL工具时,必须根据企业的具体需求,综合考虑工具的性能、灵活性和扩展性,从而构建高效、可靠的数据仓库架构。