数据挖掘是当今各行各业中不可或缺的技术之一,它帮助企业发现隐藏在大量数据中的有价值信息,进而支持决策和业务优化。在数据挖掘的过程中,数据来源是至关重要的因素,它直接影响着挖掘的结果和效率。因此,深入了解数据来源的秘密,是每个数据分析师和数据工程师都必须掌握的技能。

什么是数据挖掘?

在讨论数据来源之前,我们首先需要明确什么是数据挖掘。数据挖掘是从大量的、不规则的数据中,通过自动化或半自动化的方法,提取出潜在的、有用的信息或知识的过程。它通过统计分析、机器学习、模式识别等技术,帮助企业发现规律和趋势,做出更加精准的决策。

数据挖掘的典型应用场景包括:

- 市场营销分析:通过对客户行为数据的分析,预测消费者需求,优化营销策略。

- 金融风控:通过对历史交易数据的分析,识别潜在的欺诈行为。

- 健康管理:通过对医疗数据的分析,发现患者病情的潜在风险,预测疾病的爆发。

- 供应链优化:通过对库存、物流和销售数据的分析,优化供应链流程。

要想获得准确且有价值的挖掘结果,数据来源的质量和多样性是关键。

数据来源的多样性与挑战

在数据挖掘过程中,数据来源通常非常广泛。不同的数据来源具有不同的特点,数据类型和格式各异,整合和处理的难度也有所不同。数据来源的多样性给数据挖掘带来了很多挑战:

1. 结构化数据

结构化数据是指数据有固定的模式和结构,通常以表格形式存在,常见的数据库如 SQL数据库,包括 MySQL、Oracle、SQL Server 等。结构化数据通过行和列来表示,可以通过SQL语言进行高效查询和操作。

2. 半结构化数据

半结构化数据是指数据没有严格的结构,但包含标记或标签来组织数据。常见的半结构化数据格式包括 XML、JSON、YAML 等。虽然这些数据没有固定的表格格式,但可以通过适当的解析技术提取和处理数据。

3. 非结构化数据

非结构化数据是指没有明确组织形式的数据,通常包括文本、音频、视频、图像等。常见的非结构化数据来源包括社交媒体、用户评论、邮件、视频监控等。处理非结构化数据需要更为复杂的技术,如自然语言处理(NLP)、图像识别、语音识别等。

4. 实时数据

实时数据通常来源于各种实时传感器、在线应用和流媒体。随着物联网(IoT)、智能设备的普及,实时数据的生成量急剧增加。这类数据要求系统具备实时处理能力,以便及时捕捉到数据变化并做出反应。

5. 外部数据

企业往往会借助外部数据来丰富其数据分析的维度,外部数据包括社交媒体数据、公共数据集、市场调查数据等。这类数据的来源不稳定,且可能存在清洗和格式化的问题,但其价值巨大,能够帮助企业全面了解市场趋势和消费者行为。

数据来源的整合与清洗

在数据挖掘过程中,数据来源的整合与清洗是最为关键的环节。因为不同的数据源可能使用不同的数据格式和编码方式,如果不加以整合,数据将无法顺利流通和分析。而且,数据本身可能存在噪音、缺失值、冗余数据等问题,需要进行清洗和预处理。

1. 数据接入与整合

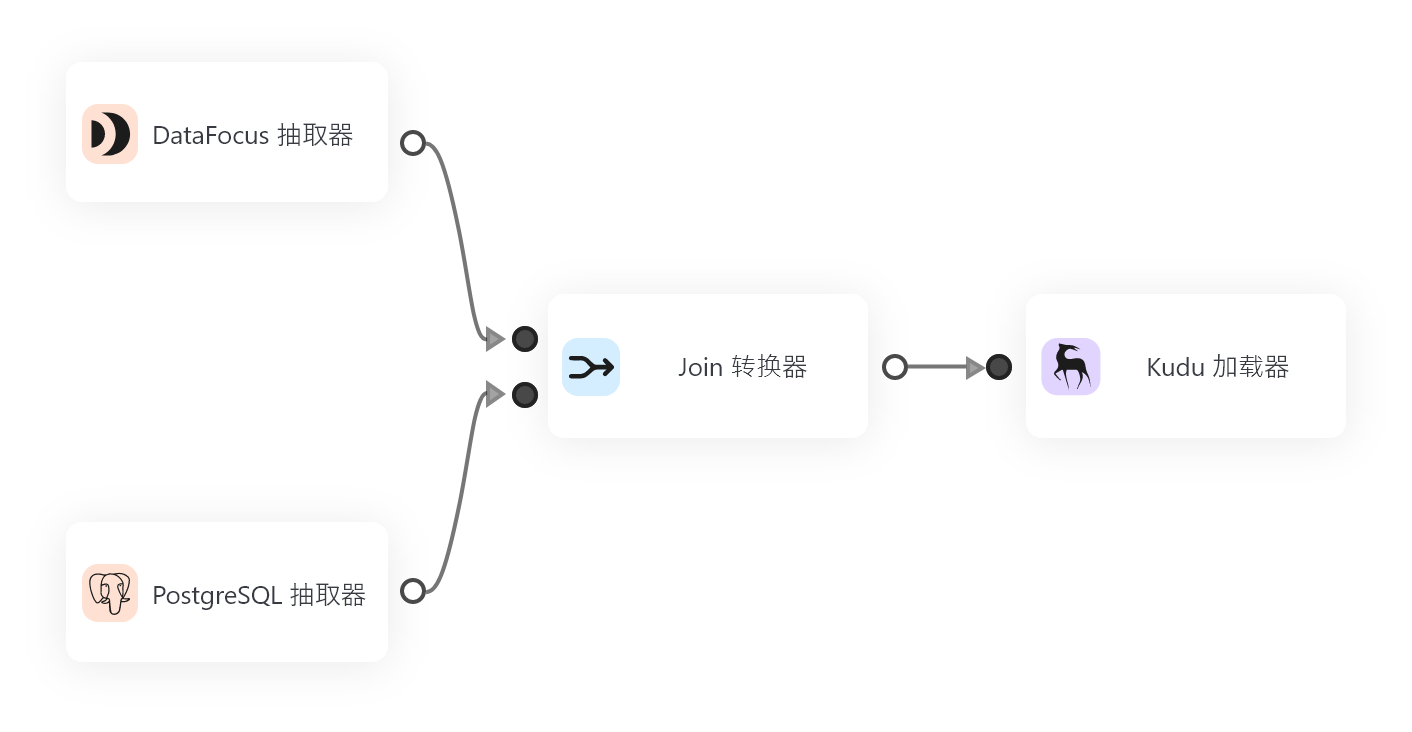

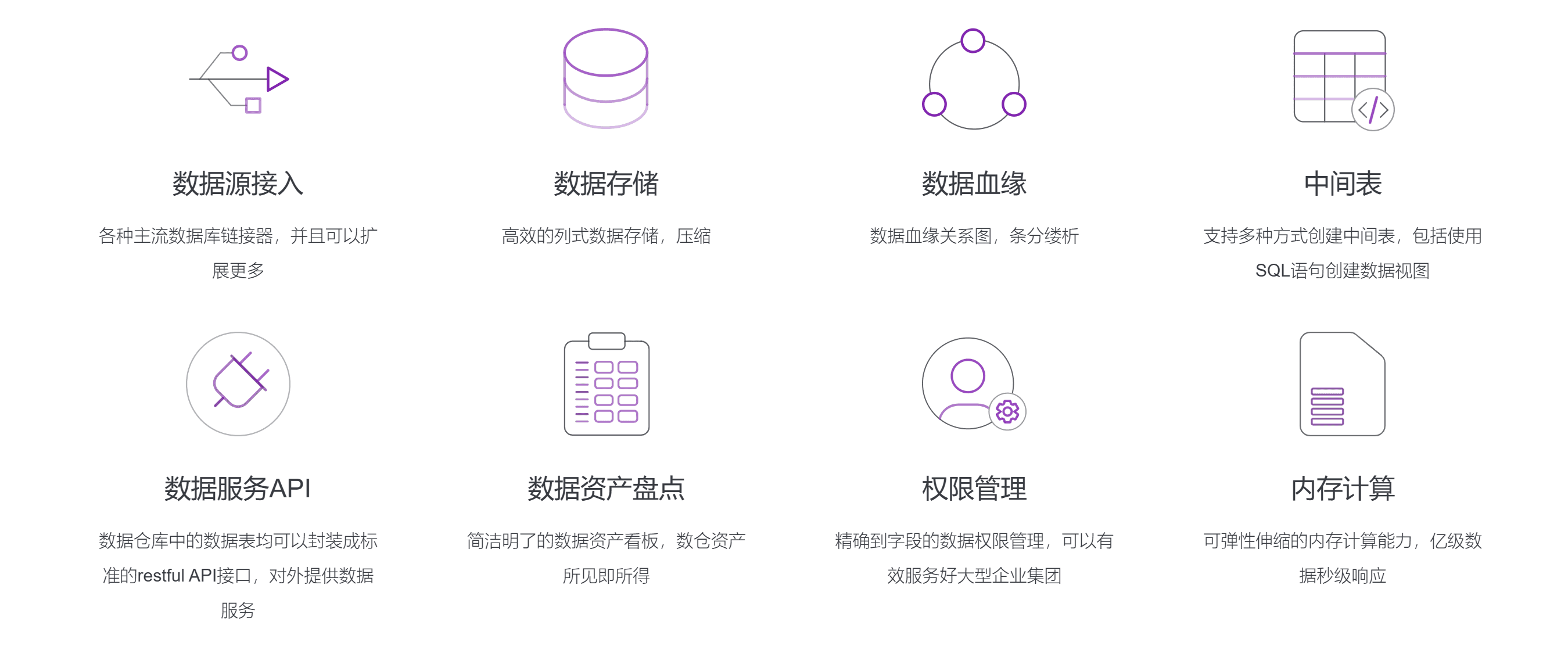

数据接入是将来自不同来源的数据导入到分析平台的过程。传统的ETL(抽取、转换、加载)工具通常用于此目的。在这一过程中,需要对数据来源的多样性、频率以及实时性进行有效管理。例如,DataFocus数仓 就是一个集数据接入、数据中间处理和元数据管理于一体的工具,能够帮助企业快速建立数据底座,实现多样化数据源的接入与整合。

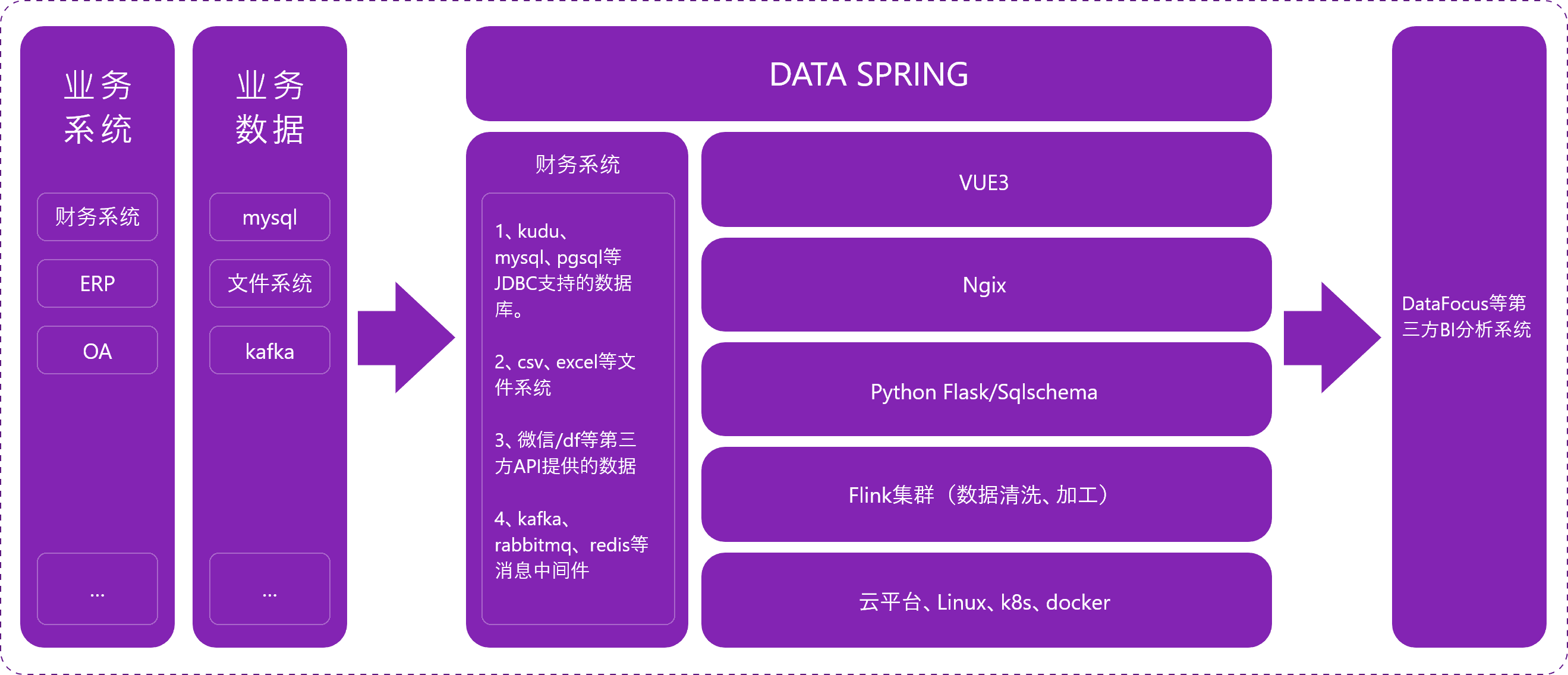

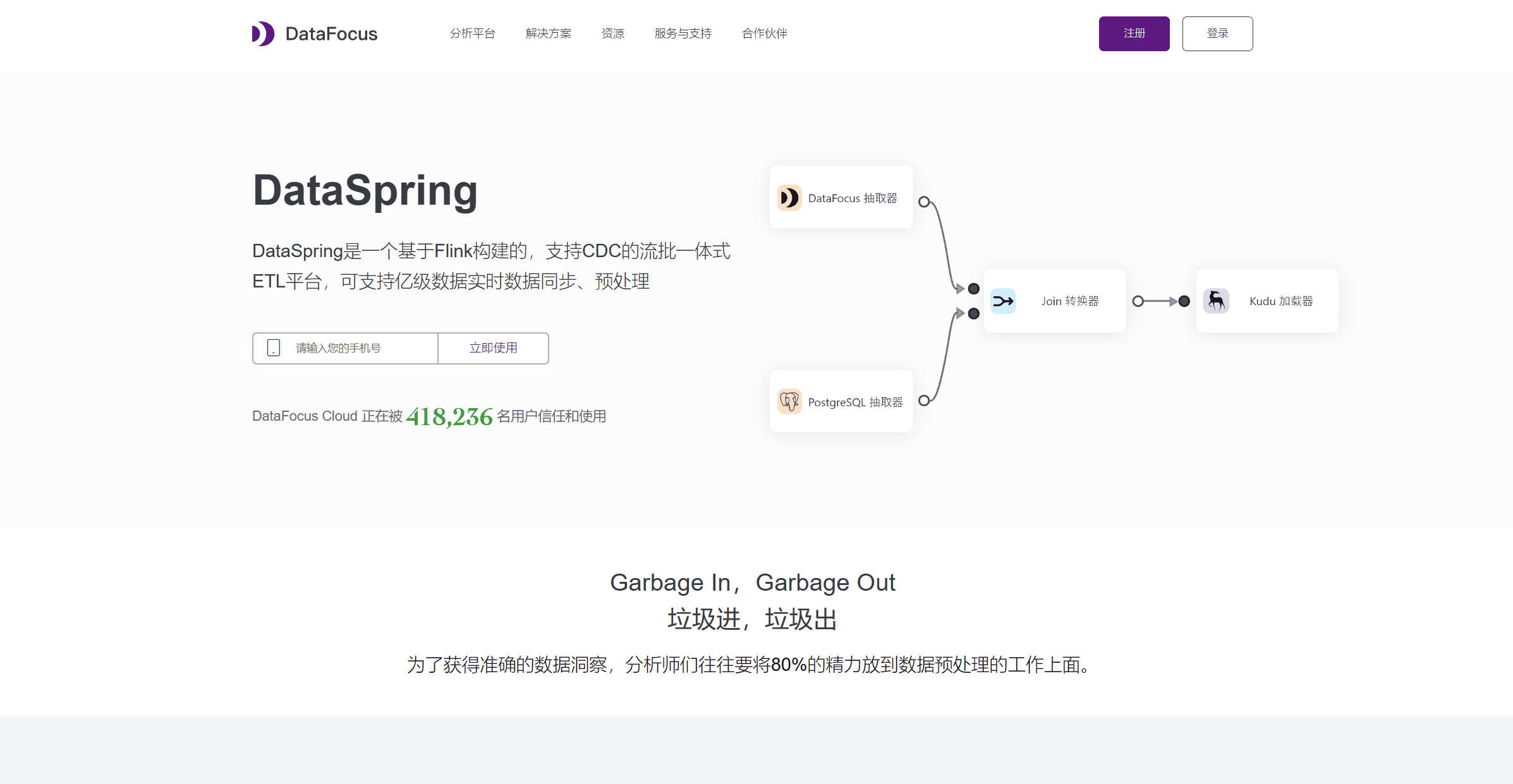

数据接入不仅限于传统的数据库,它还可以连接到API、消息队列、传感器数据流等多种来源。通过高效的API管理和数据血缘追踪,确保数据来源的可靠性和可追溯性。对于实时数据,工具如 DataSpring 采用流式架构进行ETL处理,能够精准、快速地同步各种数据源,保障实时数据的精确性和时效性。

2. 数据清洗与预处理

清洗与预处理是确保数据质量的第一步。数据清洗的目的是去除冗余、无用的、或错误的数据,同时填补缺失的数据,统一数据的格式。常见的清洗步骤包括:

- 去除重复数据:删除数据集中的重复记录。

- 填补缺失值:通过平均值、插值法或回归分析等方法填补缺失数据。

- 标准化数据:将不同尺度或单位的数据进行统一转换,使其可以进行比较。

- 异常值处理:通过统计分析方法识别并剔除异常值,避免对模型训练造成干扰。

这些清洗工作通常需要借助强大的数据处理平台,如 DataFocus数仓 和 DataSpring,以实现自动化和高效化的数据清洗过程。

数据挖掘中的数据来源优化

对于企业来说,优化数据来源的管理,提升数据质量,能够显著提高数据挖掘的效果。下面介绍几种数据来源优化的方法。

1. 统一数据管理

企业应该建立一个统一的数据管理平台,集中存储来自各个来源的数据。这不仅能够减少数据存储的冗余,还能确保数据的一致性和完整性。DataFocus数仓 就是一款能够帮助企业实现全面数据管理的工具,它不仅支持多种主流数据库的接入,还能提供元数据管理、数据血缘追踪等全链路功能,帮助企业实现高效的数据管理。

2. 增强数据的实时性

随着大数据技术的发展,实时数据的需求越来越大。企业需要采用合适的技术来提高数据的实时性。DataSpring 就是一款基于流式架构的ETL工具,能够支持实时数据处理,确保企业能够在第一时间获取到最新的数据信息。它的Log-based Change Data Capture技术可以帮助企业快速捕捉和处理增量数据,保持数据的时效性。

3. 加强数据的安全性和合规性

随着数据隐私和安全问题的日益严重,企业在进行数据挖掘时必须严格遵循法律法规,确保数据的安全性和合规性。这不仅涉及数据存储、传输过程中的加密保护,还涉及数据使用中的隐私保护措施。企业应该选择合规的数据处理工具,如DataFocus数仓和DataSpring,以确保数据的安全和合规。

总结

数据来源在数据挖掘中扮演着至关重要的角色,了解不同来源的数据特点及挑战,有助于我们更好地进行数据处理和分析。在数据挖掘过程中,企业需要注重数据的接入、清洗、预处理和实时性管理,同时借助先进的工具来实现数据的高效管理和安全处理。DataFocus数仓和DataSpring等产品,凭借其强大的数据处理能力,能够帮助企业快速构建数据底座,提升数据挖掘的效果,帮助企业实现更精准的业务决策和优化。