大数据分析已成为企业核心竞争力的关键,但想要真正掌握大数据分析,需要扎实的理论基础与实际工程能力。今天我将全方位解析大数据分析的学习路径,从数学统计知识到数据挖掘算法,从机器学习原理到实际工程实践,希望可以帮助大家更系统地掌握大数据分析的理论和实践技能。

正文:

大数据分析作为一个新兴的交叉学科,它综合应用了数据库、数据挖掘、机器学习、统计学等多门学科的知识。要成为一名出色的大数据分析师,就需要在理论和实践两方面进行全面的学习。

1. 数学统计知识

数学是大数据分析的理论基础。需要学习数学分析、线性代数等基础数学知识,并深入理解回归分析、假设检验等统计学理论。这些知识构成了大数据建模的数学基础。

例如,线性代数中的向量、矩阵运算为机器学习算法奠定了理论基础。统计学中的方差分析、相关分析等概念有助于理解模型的误差和变量相关性。掌握这些数学统计知识,可以更深入地理解机器学习算法的原理。

2. 机器学习算法

大数据环境下,机器学习算法大放异彩。需要掌握分类、回归、聚类等经典机器学习算法的原理,这是进行大数据建模的关键。还要学习神经网络等前沿的深度学习算法。

常见的机器学习算法包括线性回归、逻辑回归、决策树、随机森林、支持向量机等,这些都是进行大数据建模的重要方法。还有一些较新的深度学习算法,如各种卷积神经网络、递归神经网络等,能够建立更加复杂的非线性模型。

3. 数据挖掘技术

数据挖掘从大数据中提取有价值的信息。要学习各种数据挖掘方法,如关联规则分析、频繁模式挖掘等。数据挖掘将机器学习运用于实际场景中。

例如,可以使用关联规则分析购物篮数据,发现不同商品之间的组合关系,这对商业决策很有价值。还可以用频繁模式挖掘分析异常用户行为,发现潜在的欺诈。数据挖掘技术使我们能深入理解数据中的模式。

4. 数据可视化

大数据分析必须具备数据可视化能力,使用各类可视化库对数据进行直观的展示。数据可视化有助于发现数据规律并解释模型。

常用的可视化库有Matplotlib、Seaborn、Plotly等。可以绘制各种图表,如散点图、折线图、热力图等。数据可视化可以清晰地展示变量之间的关系,是模型解释的重要方式。

5. 分布式计算框架

要处理海量数据就需要Spark、Hadoop等分布式计算框架。学习使用这些框架进行分布式数据处理。这是实际工程中的必备技能。

这些框架可以将计算任务分发到多台机器上并行执行,充分利用集群计算能力来处理大数据。需要学习如何在这些框架上编写MapReduce、Spark程序,进行大规模数据处理。

6. 数据工程能力

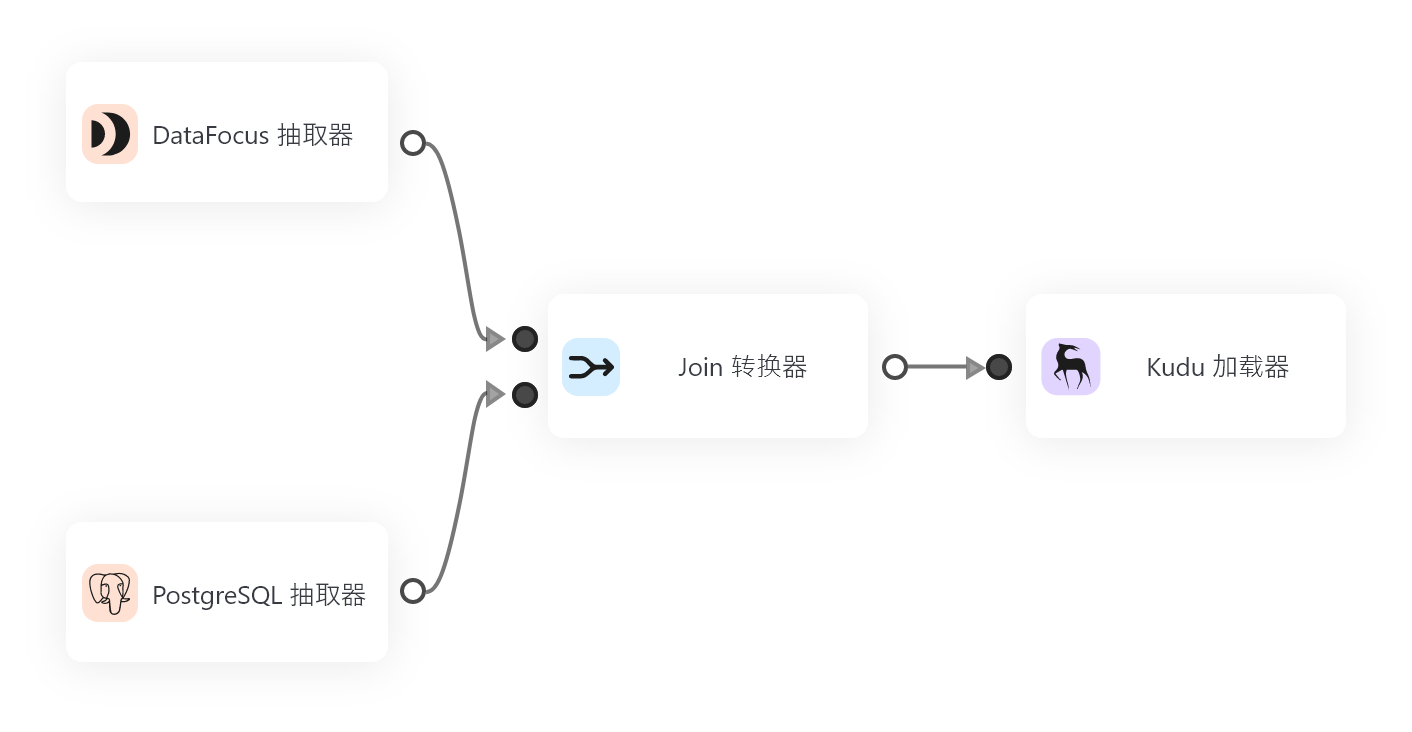

数据工程负责数据处理流程的构建和维护。数据工程师需要对数据进行采集、清洗、存储、处理等全流程操作。这需要对各类数据源、数据框架的熟练使用。

例如,需要学习使用Sqoop、Kafka等工具进行数据采集,使用Hadoop、Hive进行数据存储,使用Spark SQL、Presto进行分布式查询。数据工程能力确保整个数据流水线的顺畅运行。

7. 工程实践能力

最后要在实际项目中进行练手,完整地实现一个端到端的大数据处理流程。这需要数据工程师的软硬件综合运用能力。

通过实际项目练习使用云平台,实现数据采集、建模、服务化部署等步骤。这种实际操作经验对提高大数据分析能力至关重要。

可以看到,大数据分析既需要扎实的理论基础,也需要实际的工程实践能力。只有两者结合,才能成为真正意义上的大数据分析高手。最后,云平台和DataFocus这样的搜索式BI工具可以极大地提升工作效率,助力数据分析师更好地发挥价值。